Serviços Personalizados

Journal

artigo

Indicadores

Compartilhar

Interamerican Journal of Psychology

versão impressa ISSN 0034-9690

Interam. j. psychol. vol.43 no.3 Porto Alegre dez. 2009

Evaluación de la escritura mediante rúbrica en la educación primaria en México

Writing evaluation rubric in the elementary education in Mexico

Luis Ángel Contreras NiñoI,1; Manuel González MontesinosII; Erick Urías LuzanillaI

IUniversidad Autónoma de Baja California, México

IIUniversidad de Sonora, México

RESUMEN

Se presentan resultados de un estudio evaluativo cuyo objetivo fue caracterizar mediante una rúbrica los escritos producidos por 3,151 niños y niñas mexicanos al egresar de la educación primaria en el estado de Baja California/MX. Se describe la rúbrica utilizada y los procedimientos para capacitar en su uso a 31 jueces especialistas en lenguaje, así como para estimar la confiabilidad de sus juicios sobre los escritos. Se describen también las puntuaciones, por nivel de logro, en cada uno de los rasgos de la escritura evaluados mediante la rúbrica. Además, se aportan evidencias relacionadas con la validez del examen que incluyó el ítem de ejecución que capturó las muestras de la escritura. Finalmente, se sugieren estudios cualitativos y cuantitativos que amplíen y profundicen los hallazgos encontrados en esta evaluación a gran escala.

Palabras clave: Evaluación de la escritura; Rúbrica; Educación básica.

ABSTRACT

Results of an evaluation study to characterize using a rubric the writings produced by 3,151 Mexican children when they left primary education in the Baja California/MX state are presented. It is described the rubric used and the procedures to train 31 judges, specialists in language, in the use of the rubric, as well as the procedures to estimate the reliability of their judges about the writings. We also describe the achievement level in each trait of the writings evaluated using the rubric. We also present some evidences related with the validity of the exam in which was included the performance item that captured the writing samples. Finally, qualitative and quantitative studies are suggested to expand and deepen the discoveries found in this large scale evaluation.

Keywords: Writing evaluation; Rubric; Basic education.

El presente estudio forma parte de otro más amplio cuyo propósito es diseñar y validar un examen de español destinado a monitorear la calidad de los aprendizajes que logran en esta área los egresados de las escuelas primarias del estado de Baja California/ MX, México (Contreras, 2000; Contreras & Backhoff, 2004). El examen está alineado con el currículo oficial, por lo cual explora el dominio que tienen los examinados de las habilidades y conocimientos correspondientes a los ejes de Lengua Hablada, Lengua Escrita, Recreación Literaria y Reflexión sobre la Lengua. Se trata de una prueba de referencia criterial de gran escala, estructurada en cuatro versiones de examen que contienen 44 reactivos de opción múltiple cada una de ellas, y que incluyen también una pregunta de ensayo que captura una muestra de la escritura de los examinados. El examen fue aplicado a fines de 2001, con el apoyo del Sistema Educativo Estatal del estado de Baja California/MX, a una muestra estatal de 3,151 niños y niñas que presentaban diversas condiciones personales, escolares y familiares.

El trabajo de análisis curricular del área de español, que sirvió de base para construir la prueba, deja ver con claridad el gran énfasis que se otorga a la lengua escrita en el currículum adoptado para la educación primaria por la Secretaría de Educación Pública ([SEP], 1993) en la década pasada. Lo anterior puede ser constatado si consideramos que, en la tabla de especificaciones del examen, de un total de 182 contenidos estructurados, 84 contenidos (el 46.1 % del total del área de español) pertenecen al eje de lengua escrita.

Por tratarse de una prueba de gran escala, las especificaciones de ítems se orientaron a producir reactivos de opción múltiple. Sin embargo, el enfoque del curriculum del área de español enfatiza en gran medida el desarrollo de habilidades comunicativas de producción, principalmente en el eje de lengua escrita, que requieren para su evaluación apropiada de ítems de respuesta construida, como los de ejecución. Aunque el comité que diseñó las especificaciones de ítems de la prueba, hizo un esfuerzo considerable para que al evaluar habilidades pudiera seleccionarse alguna dimensión de ellas cuya medición con ítems de opción múltiple aportara información relevante sobre su dominio, ello no fue posible en todos los casos; por lo que las especificaciones tienden a ignorar esas partes del curriculum, a pesar de ser importantes. Una excepción a lo anterior, fue la decisión de incorporar al examen una especificación para producir ítems de ejecución orientados a capturar una muestra de la habilidad para redactar de los estudiantes, correspondiente al eje de Lengua Escrita, y que se consideró demasiado importante en el contexto del currículo como para ser ignorada en el examen. En consecuencia, los objetivos específicos de este trabajo son dar cuenta tanto de las características que tienen los escritos que produjeron los niños en respuesta a los ítems de ejecución, así como de los procedimientos utilizados para efectuar dicha caracterización.

Aspectos Psicométricos de la Evaluación de la Escritura

En la actualidad existen numerosos procedimientos para evaluar el aprendizaje del lenguaje. Entre los más importantes figuran la observación directa de la ejecución del examinado en situaciones de aprendizaje auténticas, las listas de cotejo que orientan la observación en áreas específicas del lenguaje, los registros de muestras independientes de lectura o escritura que permiten observar su desarrollo, las iteraciones o repeticiones para evaluar la construcción de significado, las autoevaluaciones de estudiantes para determinar sus percepciones acerca de tópicos específicos, las entrevistas de proceso para observar las estrategias metacognitivas del alumno, la toma de muestras de escritura en ocasiones diferentes y sobre temáticas diferentes, los círculos literarios para evaluar la construcción de significado e integrar la instrucción y la evaluación, los inventarios de intereses para planear actividades y materiales, el análisis de errores inadvertidos para evaluar estrategias de decodificación y la evaluación de ejecuciones para juzgar la aplicación de estrategias, habilidades y conocimientos e integrar la evaluación con la instrucción, entre otros (Cooper, 1997).

En nuestro idioma, destaca la propuesta que formulan Bazán, Sánchez, Corral-Verdugo y Castañeda (2006) para emplear un sistema analítico, mediante ecuaciones estructurales, útil al estudio del aprendizaje y dominio de la lengua escrita, mismo que puede:

ayudar a describir y explicar los patrones de relaciones de los resultados de los niños en pruebas de evaluación de desempeño, con otras mediciones, con la medición de otros rasgos o características del niño, y con el uso de distintos criterios de medición, lo cual se establece a partir de datos de diferencias individuales. (p. 96)

Tales procedimientos tienen en común que se refieren a la evaluación de ejecuciones, las cuales son definidas, según los principales estándares psicométricos para la evaluación psicológica y educativa, como medidas basadas en conductas o en productos, las cuales se establecen para emular contextos o condiciones de la vida real en las cuales se aplican conocimientos o habilidades específicos (American Educational Research Association, American Psychological Association, &National Council on Measurement in Education [AERA, APA, & NCME], 1999).

Dichos procedimientos han tenido su principal aplicación en el ámbito del salón, para investigar el aprendizaje, retroalimentar la instrucción o fundamentar la promoción de grado. Sin embargo, en la última década algunos de ellos han venido utilizándose con éxito en el contexto de la evaluación a gran escala, complementando a las tradicionales pruebas estandarizadas de opción múltiple que cumplieron esa función durante mucho tiempo. Entre ellos, destaca la evaluación de la escritura mediante una matriz de evaluación, también llamada confirmación de respuestas o rúbrica, como aquí se le denominará en adelante.

Se trata de una técnica para evaluar la construcción de significados mediante la escritura, que proporciona una vía para juzgarla mediante el examen de una muestra completa. Una rúbrica es una escala que describe uno o varios tipos y niveles de habilidad respecto a una ejecución determinada. Para ello, proporciona una guía para calificar que diferencia, en una escala articulada, entre un grupo de muestras producidas por estudiantes que responden la misma tarea evaluativa y al hacerlo sus ejecuciones se dispersan en un rango que abarca desde una respuesta excelente, hasta una que resulta inapropiada y necesita mejorar (University System of Georgia [USG], 2002).

Toda rúbrica se enfoca en la medición de cierto constructo, utiliza un rango para ordenar la ejecución y contiene características de actuación específicas arregladas en niveles que indican el dominio de un estándar.

A diferencia de los ítems de opción múltiple, que se enfocan en habilidades incrementales y son una vía indirecta para evaluar dimensiones discretas de habilidades comunicativas tales como la ortografía, gramática y el uso de otras convenciones lingüísticas, la evaluación mediante rúbrica es una aproximación directa a la evaluación de la escritura, en la cual se pide al estudiante que escriba uno o más ensayos que son evaluados mediante algún método de calificación como el analítico, holístico o el de la habilidad primaria. La mayoría de los ensayos son escritos por demanda en respuesta inmediata a un instigador (prompt) verbal.

En el contexto de la evaluación del lenguaje se considera que la buena escritura es algo más que el empleo correcto de la gramática o el uso adecuado de la estructura de las oraciones o párrafos. Tales elementos de una muestra de escritura son importantes, pero lo es más la necesidad del autor de comunicar información, pensamientos e ideas. Ese es el verdadero propósito de la escritura (Swift, 2003).

En consecuencia, se requiere de una estrategia evaluativa que dé cuenta de la capacidad del estudiante para escribir, que lo ayude a analizar y mejorar su escritura mediante estándares de ejecución específicos, así como que proporcione un lenguaje común a planeadores, autoridades educativas, supervisores escolares, profesores, padres de familia y a los propios estudiantes, de manera que se mejore la comprensión y se reduzcan posibles confusiones al discutir y evaluar una muestra de la escritura de los alumnos.

En este sentido, el uso de la rúbrica en el contexto del salón y en el de la gran escala presenta ventajes importantes, entre las que destacan la promoción de expectativas consensuadas, conocimiento previo por parte del estudiante de los criterios para calificar su ejecución, reducción de la subjetividad del evaluador y la promoción de su consistencia al calificar, retroalimentación de la efectividad de la instrucción, promoción de estándares contra los cuales medir y documentar el progreso, apoyo a la rendición de cuentas y un enfoque integral del contenido, la ejecución, los estándares de ejecución y el trabajo del estudiante.

Existen dos tipos generales de rúbrica:

La Holística. Se emplea para medir el efecto global que produce en un evaluador una tarea evaluativa, con una guía diseñada para obtener una impresión general. Este tipo de rúbrica constituye una aproximación cualitativa, rápida y eficiente para juzgar una ejecución; sin embargo, no es una medida apropiada cuando se requiere evaluar qué tan bien el estudiante aplicó habilidades o conceptos específicos.

La Analítica. Se utiliza para calificar una tarea evaluativa mediante la asignación de puntajes en cada uno de los rasgos o elementos que la constituyen. Resulta apropiada cuando se desea comparar a estudiantes en cuanto a sus conocimientos, habilidades o la aplicación de ellos, contra estándares de excelencia. Es cuantitativa, subjetiva y puede no ser apropiada para algunas tareas evaluativas.

Un aspecto crítico del uso de una rúbrica es el entrenamiento de los evaluadores. Las personas involucradas en el proceso de calificación, deben participar en sesiones de entrenamiento que involucran una detallada discusión de la rúbrica y realizar sesiones de ensayo, en las que asignen a los escritos que sirven de prueba un porcentaje mínimo de puntajes exactos de acuerdo con los previamente establecidos por los coordinadores del examen. Los evaluadores que resultan incapaces de obtener los estándares correspondientes, en cuanto a lograr una comprensión cabal de la rúbrica y los criterios para asignar calificaciones, tras repetidos intentos y una realimentación adecuada, no participan en la evaluación real.

Método

En esta sección se describen los participantes en el estudio, los materiales utilizados y los procedimientos que se emplearon para diseñar una rúbrica analítica para evaluar las respuestas a las preguntas de ensayo del examen de español. También se describen los procedimientos empleados para entrenar a evaluadores en el uso apropiado de la rúbrica y para garantizar la confiabilidad de sus juicios al calificar los ensayos de los examinados. Además, se describen los procedimientos que se siguieron para analizar la información derivada de la aplicación de la rúbrica, así como para contrastar los resultados obtenidos al utilizar la rúbrica con aquellos que lograron los niños y niñas en los reactivos de opción múltiple del examen, mismos que exploraron su dominio de los contenidos correspondientes a las líneas de formación que contempla el eje de Lengua Escrita del área de español.

Participantes

Como ya se mencionó, el examen fue aplicado a fines de 2001 a una muestra estatal estratificada de examinados conformada por 3,151 niños y niñas que egresaron en el ciclo escolar 2000-2001, de 48 escuelas de educación primaria en Baja California/MX, cuando ingresaron a la escuela secundaria. En conjunto, los examinados presentaban diversas condiciones en cuanto a municipio y delegación donde estudiaron, tipo de control de la escuela, turno escolar al que asistieron, nivel socioeconómico de la familia y otras variables contextuales más que fueron exploradas.

También participaron en el estudio profesores, egresados, y estudiantes avanzados de carreras relacionadas con el lenguaje, a quienes se habilitó como evaluadores.

Materiales y Procedimientos

Los principales materiales que fueron empleados en el estudio, incluyen la especificación de reactivos y los ítems mediante los cuales se capturó la muestra de la escritura de los examinados, la rúbrica que se utilizó para calificar los ensayos producidos por los niños y niñas que fueron evaluados y los materiales que se emplearon para capacitar a los evaluadores que emplearon la rúbrica para calificar los ensayos.

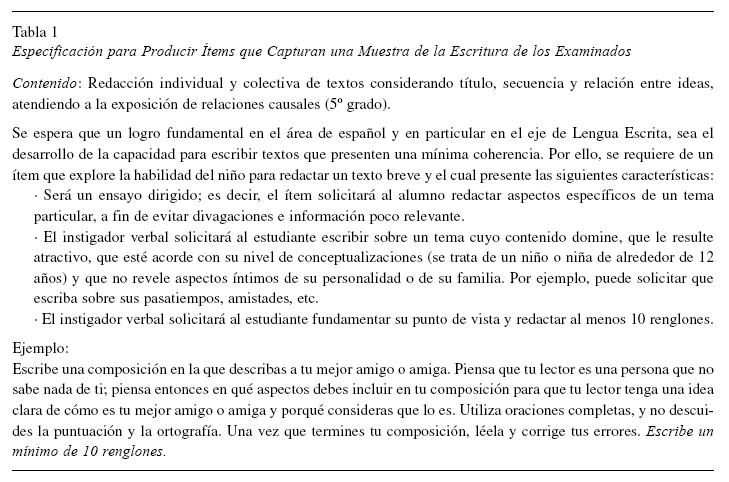

La Tabla 1 presenta la especificación que produjo los cuatro ítems de ensayo, misma que también ilustra uno de ellos.

Puesto que una evaluación de ejecución no tiene una clave de respuesta correcta o incorrecta absoluta, se requieren reglas más detalladas para calificar. Así, se requería una rúbrica para evaluar los ensayos de los examinados. Para ello, se consideraron varias rúbricas existentes para evaluar la escritura a fin de encontrar la más apropiada para explorar el dominio de la habilidad de redacción, según lo establece el contenido que aparece en el programa de estudios de 5º grado (véase la descripción del contenido a evaluar en la Tabla 1).

Al respecto, se consideró que dadas las características de los escritos producidos por los niños y niñas como su brevedad, respuesta a un instigador, dominio previo del contenido y otras relacionadas, podría utilizarse una rúbrica desarrollada dentro del modelo de escritura de 6+1 rasgos, propuesto a principios de los años ochenta del siglo pasado por investigadores del laboratorio psicométrico regional del noroeste de los Estados Unidos (Kozlow & Bellamy, 2005; Northwest Regional Educational Laboratory [NWREL], 2001). De manera específica, se tradujo y adaptó la rúbrica desarrollada para evaluar a nivel estatal la escritura en los grados K3 a K5 (Wolfe, Dalton, & Neuburger, 1993), mismos entre los que se encuentra el que corresponde al egreso de la educación primaria en México. La Tabla 2 presenta una breve descripción de los rasgos de la rúbrica que se utilizó para evaluar los escritos de los examinados que respondieron las preguntas de ensayo.

Por su parte, cada uno de los seis rasgos fue evaluado en una escala de seis niveles de ejecución, correspondiendo el 6 a la mejor ejecución y el 1 a la más deficiente. En consecuencia, la calificación máxima posible fue 36 puntos y la mínima 6.

Con el propósito de ilustrar la escala de calificaciones que se utilizó al medir cada rasgo de la escritura considerado en la rúbrica, en la Tabla 3 se muestran los niveles de ejecución que fueron considerados por los jueces para evaluar el primero de los rasgos de la escritura de los niños; es decir, el que se refiere a las ideas y contenido incluidos en los escritos producidos por los examinados.

Selección y Entrenamiento de los Evaluadores

Las características de la evaluación de la ejecución a gran escala mediante ítems de respuesta construida hacen que resulte compleja, tardada y costosa. Los principales requerimientos para ello incluyen el desarrollo de matrices de evaluación o rúbricas, la selección y entrenamiento de jueces expertos, y la operación de prolongadas sesiones de evaluación. En consecuencia, tras su aplicación a gran escala, los ensayos de los niños no pudieron ser evaluados de inmediato por falta de recursos humanos y financieros, sino hasta recientemente.

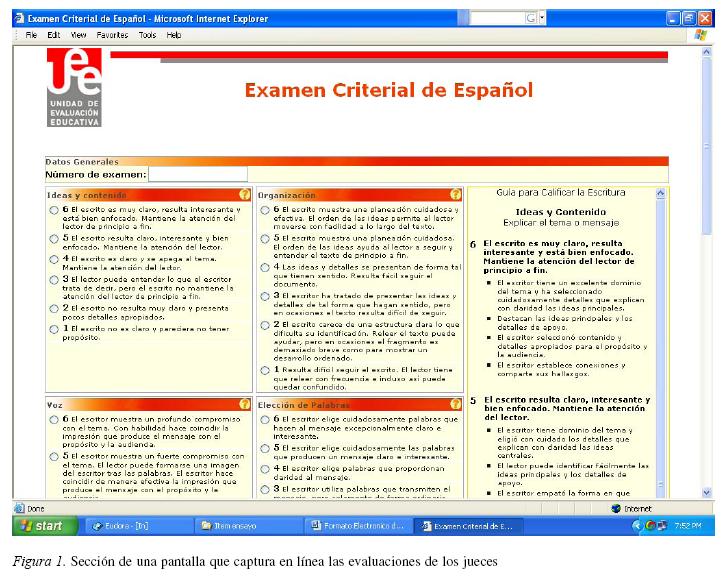

Para ello, se hizo una convocatoria a egresados y estudiantes avanzados de la carrera Lengua y Literatura de Hispanoamérica, del campus Tijuana/MX de la Universidad Autónoma de Baja California, y a profesores de español de la Escuela Normal Estatal de Ensenada, Baja California/MX, a quienes se dio un entrenamiento específico en el manejo de matrices de evaluación de la escritura, particularmente en cuanto al uso de la rúbrica desarrollada. La capacitación se hizo en dos sesiones e incluyó también el entrenamiento de dichos especialistas para lograr estabilidad de sus observaciones y juicios, a fin de garantizar índices aceptables de confiabilidad en sus calificaciones. Además, se proporcionó una preparación en el manejo de procedimientos automatizados para la captura de sus juicios, mediante una base de datos que operó en línea desde una página Web que se diseño para tal efecto (Ver Figura 1). Así, 31 jueces calificaron cada uno de ellos 100 ensayos durante aproximadamente un mes.

Resultados y Discusión

En esta sección se presentan los principales resultados obtenidos durante el proceso de calificar los ensayos por parte de los jueces, los obtenidos por los niños y niñas en los ensayos calificados mediante la rúbrica y los alcanzados por ellos en las demás partes del examen que exploraron el dominio de los contenidos de lengua escrita.

Análisis de la Confiabilidad de los Juicios Emitidos por los Evaluadores

La interpretación válida de los puntajes en la rúbrica depende sustancialmente de la confiabilidad de los jueces que calificaron las ejecuciones. La confiabilidad de los jueces es una propiedad del proceso de medición y como tal debe ser determinada en cada ejercicio particular del proceso. Para estimar la confiabilidad se identificaron tres aproximaciones psicométricas aplicables en este caso.

Aproximación a la Confiabilidad Basada en la Consistencia entre Jueces. En esta aproximación se toma como base el cálculo el Coeficiente α de Cronbach como una medida del grado en que los puntajes asignados por jueces múltiples convergen para medir un constructo en común. El coeficiente α es una medida de consistencia interna de las calificaciones. Si el estimado resulta bajo, implica que la variabilidad en los puntajes combinados se debe a variabilidad atribuible al error aleatorio y no al puntaje verdadero en el constructo de interés (Hatcher, 1998).

Para este caso, se desagregó la base de datos del ítem 45 de la prueba para analizar los puntajes de los seis rasgos en cada versión del examen por separado. Así, los coeficientes correspondientes a los puntajes otorgados por los jueces se muestran en la Tabla 4.

Como los tamaños originales de muestra son considerables, se seleccionó una muestra aleatoria de 50 casos de cada modelo y se repitió el cálculo para descartar que los coeficientes se inflen artificialmente debido al tamaño de muestra en cada forma o versión del examen. Los resultados con 50 casos se muestran en la Tabla 5.

Como puede observase en ambos casos los coeficientes alfa son superiores a .90, lo que definitivamente constituye una razón sólida para concluir que las calificaciones otorgadas por los jueces son consistentes y convergen en un constructo común.

Aproximación a la Confiabilidad Basada en el Proceso de Medición. Otra aproximación que se empleó para estimar la confiabilidad entre jueces se basa en la información que proporciona el procedimiento de medición en su conjunto. Esta aproximación se implementa realizando un análisis de componentes principales (ACP) sobre los datos de cada escala. Este método es de aplicación óptima cuando la escala que se analiza se ha diseñado para medir un sólo constructo unidimensional (e.g. competencia en escritura).

Los puntajes otorgados por los jueces se someten al ACP para determinar la cantidad de varianza compartida que se puede atribuir al primer componente extraído. El porcentaje de varianza explicada por el primer componente proporciona una indicación del grado en que los jueces están coincidiendo. Si el porcentaje de varianza es alto (e.g. 60%), se tiene también una indicación de que los jueces están valorando un constructo unidimensional (Stemler, 2004).

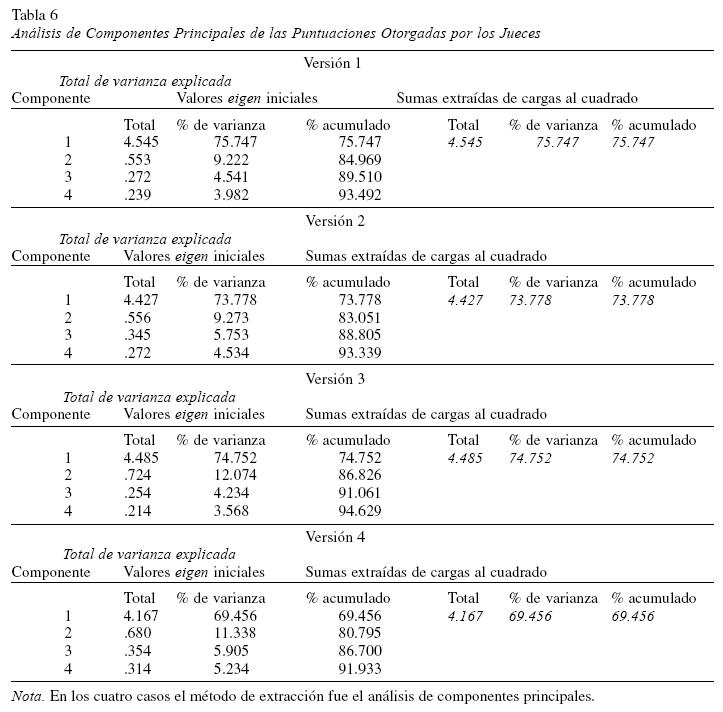

Se aplicó el procedimiento sobre las bases desagregadas por forma/versión del examen y se obtuvieron los resultados que se muestran a continuación en la Tabla 6 compuesta.

Como puede verse en la Tabla compuesta, el procedimiento ACP extrajo sólo un componente principal con valor eigen superior a 1. En todos los casos el porcentaje de varianza explicada por el componente es superior al 60%.

La ventaja de esta aproximación es que permite asignar puntajes finales a los examinados con base en la dimensión de mayor peso; es decir, el primer componente principal. La desventaja es que se asume que los puntajes de los jueces están exentos de error de medición.

Aproximación a la Confiabilidad de los Jueces Basada en el Modelo de Rasch. El modelo Rasch de facetas múltiples fue propuesto por Linacre (1994), para analizar de forma exhaustiva la contribución individual de cada faceta y de cada elemento en un proceso de medición. En el caso particular del ítem de ensayo las tres facetas son: los jueces, los examinados y los ítems de la escala para cada rasgo. Específicamente, el modelo permite estimar la severidad de los jueces, la habilidad de los examinados y la dificultad de los ítems. Con propósitos de ilustración, la Figura 2 muestra la salida de resultados del análisis efectuado con el programa de cómputo denominado FACETS (Linacre, 1994), que compara la severidad de los jueces en la versión 1 de la prueba.

Los estadígrafos de ajuste interno (Infit) y externo (Outfit) indican el grado en que el comportamiento de cada juez se ajusta a las expectativas del modelo Rasch, tomando en cuenta la calibración individual de severidad obtenida para cada juez. Por regla general los valores Infit y Outfit, en Mean Square (MsSq), deben mantenerse dentro del intervalo .80 a 1.30. Para los valores estandarizados (ZStd) el rango aceptable es de -2 a +2.

La aproximación vía FACETS permite además obtener una estimación de la consistencia intra-juez. En particular, los valores Infit y Outfit proporcionan una medida del grado en que las calificaciones otorgadas por los jueces son internamente consistentes, al mantenerse dentro de la expectativa que el modelo Rasch crea para cada juez, dado su patrón observado de calificaciones emitidas dentro del proceso en su conjunto. Valores de Infit MsSq mayores a 1.30 indican mayor variabilidad intra-juez que la que se esperaría con base al modelo (Stemler, 2004).

Esta aproximación tiene la ventaja de no requerir que todos los jueces califiquen todos los ítems para lograr una estimación de la confiabilidad entre jueces, como fue el caso al calificar los escritos producidos en respuesta a los ítems de la prueba. En lugar de ello, los jueces pueden calificar un subconjunto particular de ítems y, mientras exista suficiente conectividad (Linacre, 1994; Linacre, Englehard, Tatum, & Myford, 1994) entre jueces y calificaciones, será posible comparar directamente a los jueces.

La Figura 2 presenta un reporte de la medición de los jueces; esto es, un indicador del nivel de severidad de cada juez en lo individual, junto con varios estadísticos de ajuste que ayudan a diagnosticar en qué medida cada juez fue consistente con su propio uso de la rúbrica para evaluar los ensayos. La utilidad de la información en la figura radica en que puede ser comparada simultáneamente la severidad relativa de todos los jueces. Así, los índices de severidad de los jueces (Measure) son útiles para estimar en qué medida existen diferencias sistemáticas entre jueces respecto a su nivel de severidad y, en su caso, proceder a ajustarlas.

Con las estimaciones sobre la confiabilidad de los jueces mediante los métodos antes descritos fue posible determinar los grados de severidad o laxitud de los jueces y sobre todo verificar que estas diferencias se conservaban dentro de un límite previsible en cada versión de la prueba, lo que permitió concluir que los resultados obtenidos de la evaluación de los escritos son interpretables.

Características Generales de la Escritura de los Egresados de la Educación Primaria en Baja California/MX

En consecuencia, se procedió con confianza a determinar las puntuaciones generales otorgadas por los jueces mediante la rúbrica, al total de los ensayos. Estos resultados se presentan en la Tabla 7.

Por su parte, las calificaciones que otorgaron los jueces a los ensayos producidos en respuesta al ítem, correspondientes a cada versión de la prueba, se muestran en la Tabla 8.

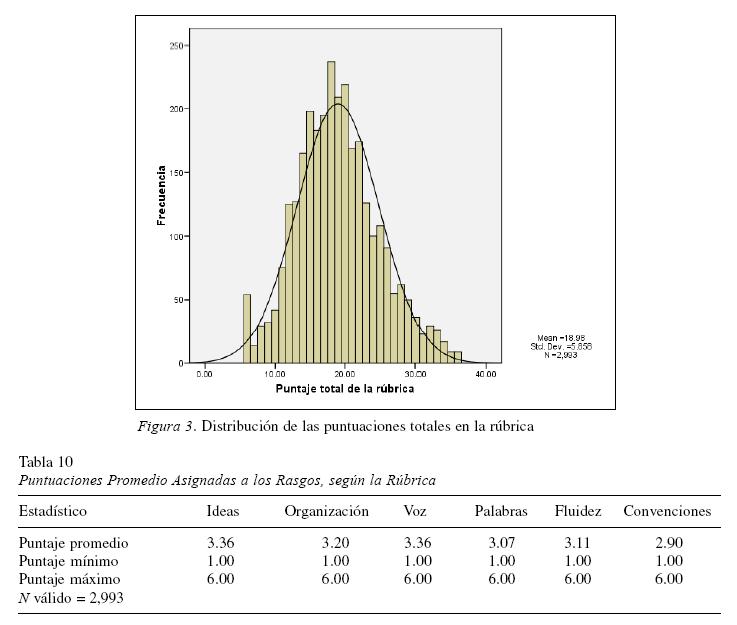

De conformidad con la rúbrica, el conjunto de los jueces que calificaron los escritos que produjeron los examinados en respuesta a los cuatro ítems que instigaban su redacción de al menos 10 renglones sobre un tema familiar a ellos, asignaron al conjunto de ensayos las siguientes puntuaciones totales (Ver Tabla 9 y Figura 3)

Puntuaciones Promedio en los Rasgos

Las puntuaciones promedio asignadas por los jueces a cada uno de los rasgos de la escritura de los estudiantes se muestran en la Tabla 10. Como puede observarse, casi todos los rasgos fueron evaluados con un puntaje promedio por encima del nivel 3 en una escala donde 1 es la calificación mínima y 6 la máxima. Una excepción fue el rasgo de la escritura denominado Apego a las convenciones de la lengua, que resultó ligeramente inferior. Los rasgos mejor evaluados fueron las ideas o contenido de los escritos y la voz del escritor, con puntuaciones promedio de 3.36.

Nivel de Dominio en Cada Rasgo de la Escritura

En opinión del conjunto de jueces, el nivel de dominio que mostraron los niños en cada rasgo de su escritura se muestra en la Tabla 11. Para cada rasgo se presenta la frecuencia y el porcentaje de examinados que fueron ubicados en cada uno de los niveles de dominio, según la rúbrica utilizada.

Por su parte, la Tabla 12 relaciona la ejecución en la rúbrica con los conocimientos y habilidades cuyo dominio fueron explorados con ítems de opción múltiple.

A partir de la información contenida en la Tabla 12 se pueden formular las siguientes observaciones: Las celdas identificadas con 1 presentan las correlaciones más altas, mismas que se dieron entre el total de conocimientos y habilidades que fueron explorados con ítems de opción múltiple y cada una de las líneas de formación que lo integran, así como con la calificación total de la rúbrica y el rasgo de ésta denominado Convenciones. Lo mismo sucede con las correlaciones entre la calificación total en la rúbrica y los rasgos que la integran. Por su parte, las celdas identificadas con 2 presentan correlaciones moderadamente altas que se dan entre los propios rasgos de la rúbrica. En cuanto a las celdas identificadas con 3 presentan correlaciones moderadas entre el total de conocimientos y habilidades que fueron explorados con ítems de opción múltiple y todos los rasgos de la rúbrica, así como entre la ortografía relacionada con el manejo de letras y sílabas y las demás variables que aparecen en la matriz. Las relaciones mencionadas, así como las demás que resultaron bajas pero significativas, muestran que existe coherencia entre todos los aspectos relacionados con la escritura, como fueron evaluados en el examen de español.

Conclusiones y Sugerencias

La realización del presente estudio evaluativo permitió obtener resultados y experiencias importantes que permiten formular las siguientes conclusiones y recomendaciones:

Resulta claro que la evaluación a gran escala de la ejecución de los estudiantes, referida a la aplicación de conocimientos y habilidades de lenguaje como en el caso de la redacción, resulta posible y es más significativa si se lleva a cabo mediante procedimientos como la rúbrica descrita, en vez explorarlos sólo a través de los tradicionales ítems de opción múltiple. Aunque el uso de ítems de respuesta construida en la evaluación a gran escala resulta complejo, prolongado y costoso en términos de los recursos humanos y materiales involucrados, vale la pena en el contexto de una evaluación nacional o estatal como la que aquí se describe.

Los resultados muestran que la rúbrica seleccionada, traducida y adaptada se ajustó al nivel de competencia comunicativa de los examinados y fue útil para describir las características de su escritura cuando egresan de la educación primaria. Prueba de ello es que, con pequeñas diferencias, la ejecución de los niños y las niñas fue similar y estuvo en el rango en todos los rasgos de la escritura cuyo dominio explora la rúbrica.

Al describir el presente estudio se enfatizó en el asunto de la confiabilidad de los juicios de los evaluadores que calificaron los ensayos mediante la rúbrica debido a que, por problemas operativos, no fue posible conseguir suficientes especialistas que apoyaran la evaluación bajo las condiciones del estudio (tiempo disponible para la capacitación, número de ensayos a evaluar, etc.). Ello ocasionó que ningún escrito pudiera ser evaluado por dos o más jueces independientes para calcular la confiabilidad mediante su grado de acuerdo. En consecuencia, fue necesario explorar la literatura especializada en el tema de la confiabilidad hasta encontrar métodos apropiados para estimar la confiabilidad en esas condiciones. Así, fue posible obtener una estimación razonable al conjuntar el coeficiente α de Cronbach como una medida del grado en que los puntajes asignados por jueces múltiples convergen para medir un constructo en común; el análisis de componentes principales sobre los datos de cada escala cuando se ha diseñado para medir un constructo unidimensional, como la competencia en escritura, a fin de asignar puntajes finales a los examinados con base en la dimensión de mayor peso; y mediante el uso de la extensión del modelo de Rasch, denominada de facetas múltiples, que hace posible determinar los grados de severidad o laxitud intra-juez e inter-juez para verificar que estas diferencias se conserven dentro de un limite previsible. El uso de tal estrategia convergente permitió concluir que los resultados obtenidos al evaluar los escritos eran interpretables.

Considerando de manera global la ejecución de los examinados, sus puntuaciones en la rúbrica están ligeramente sesgadas hacia las calificaciones bajas. Así, los puntajes promedios en los rasgos evaluados en la rúbrica apenas rebasan o están cerca de la calificación 3 en cada escala. Además, las frecuencias y porcentajes de examinados por nivel de dominio en cada rasgo evaluado, también se centran en el nivel de dominio 3.

Al relacionar las calificaciones obtenidas por los examinados en la rúbrica con los aciertos en otras partes del examen que se refieren al dominio de la lengua escrita, se observan correlaciones significativas en todos los casos, y son muy altas (superiores a .74) entre el total en la rúbrica y los rasgos que la conforman, así como altas (superiores a .35) entre el total en conocimientos y habilidades en lengua escrita y las líneas de formación que están incluidas en dicha sub-área. Las demás relaciones resultaron bajas pero significativas. Estos resultados muestran que existe alta congruencia y coherencia en los aspectos involucrados en la escritura, como son evaluados en el examen, y constituyen evidencias de validez de la prueba.

Los resultados en este estudio se consideran preliminares. Por ejemplo, las relaciones entre los rasgos de la rúbrica y otras líneas de formación evaluadas en el examen solo consideran las correlaciones entre sus puntuaciones. Por ello, se consideran necesarios estudios cualitativos y cuantitativos que saquen el máximo provecho a los cuantiosos datos recabados mediante esta evaluación a gran escala. En particular, se sugieren un estudio lingüístico de los escritos y otro para desarrollar un modelo causal como el que proponen Bazán et al. (2006), que relacione las puntuaciones en los rasgos de la rúbrica con los resultados en las líneas de formación relacionadas con la escritura que se exploran en el examen. También se sugiere replicar el estudio en otros países hispanoparlantes para comparar las características de los escritos que en ellos se producen.

Referencias

American Educational Research Association., American Psychological Association., & National Council on Measurement in Education. (1999). Standards for educational and psychological testing. Washington, DC: Author. [ Links ]

Bazán, A., Sánchez, B., Corral-Verdugo, V., & Castañeda, S. (2006). Utilidad de los modelos estructurales en el estudio de la lectura y la escritura. Revista Interamericana de Psicología, 40(1), 85-93. [ Links ]

Contreras, L. A. (2000). Desarrollo y pilotaje de un examen de español para la educación primaria en Baja California/MX. Unpublished master’s dissertation, Instituto de investigación y Desarrollo Educativo, Universidad Autónoma de Baja California, Ensenada, México. Retrieved from http://eduweb.ens.uabc.mx/egresados/Tesis/indicetesis.htm

Contreras, L. A., & Backhoff, E. (2004). Metodología para elaborar exámenes criteriales alineados al currículo. In S. Castañeda (Ed.), Educación aprendizaje y cognición, teoría en la práctica (chap. 10). México, DF: Manual Moderno. [ Links ]

Cooper, J. D. (1997). Literacy: Helping children construct meaning (3nd ed.). Boston: Houghton Mifflin. [ Links ]

Hatcher, H. (1998). Using the SAS System for factor analysis and structural equations modeling. Cary, NC: The SAS Institute. [ Links ]

Kozlow, M., & Bellamy, P. (2005). Research on the 6+1 trait writing model for improving student writing. Retrieved February 22, 2007, from http://www.nwrel.org/ascd05/ [ Links ]

Linacre, J. M. (1994). Many-facet Rasch measurement. Chicago: MESA. [ Links ]

Linacre, J. M., Engelhard, G., Tatum, D. S., & Myford, C. M. (1994). Measurement with judges: Many-faceted conjoint measurement. International Journal of Educational Research, 21(6), 569-577. [ Links ]

Northwest Regional Educational Laboratory. (2001). Assessment: About 6+1 traitTM writing. Retrieved December 18, 2007, from http://pareonline.net/getvn.asp?v=9&n=4 [ Links ]

Secretaría de Educación Pública. (1993). Educación básica. Primaria. Plan y programas de estudio. México, DF: Author. [ Links ]

Stemler, S. E. (2004). A comparison of consensus, consistency, and measurement approaches to estimating interrater reliability. Practical Assessment, Research & Evaluation, 9(4). Retrieved from http://PAREonline.net/getvn.asp?v=9&n=4 [ Links ]

Swift, B. (2003). The mandate of a writing assistant. Santa Cruz, CA: University of California. Retrieved October 22, 2007, from http://people.ucsc.edu/~davidlaw/Swift.html [ Links ]

University System of Georgia. (2002). Assessment module 9. Post secondary model for integrating technology. Retrieved January 03, 2003, from http://ci.colstate.edu/psit/An%20Assessment%20Overview.htm [ Links ]

Wolfe, B., Dalton, M., & Neuburger, W. (1993). Oregon statewide writing assessment 1991 and 1992. (ERIC Document Reproduction Service No. ED366960). [ Links ]

Received 13/11/2008

Accepted 02/03/2009

Luis Ángel Contreras Niño. Universidad Autónoma de Baja California, México.

Manuel González Montesinos. Universidad de Sonora, México.

Erick Urías Luzanilla. Universidad Autónoma de Baja California, México.

1 Dirección: Universidad Autónoma de Baja California, Instituto de Investigación y Desarrollo Educativo, A. P. 453, Ensenada, BC, México, C.P. 22800. E-mail: angel@uabc.mx.