Serviços Personalizados

Journal

artigo

Indicadores

Compartilhar

Actualidades en psicología

versão On-line ISSN 0258-6444

Actual. psicol. v.19 n.106 San José 2003

Escala de actitudes hacia la tecnología en el aprendizaje escolar aplicada a niños y niñas de primaria pública en Costa Rica. Análisis de validez y confiabilidad

Rodrigo Vargas Ruiz*

Universidad Nacional, Heredia, Costa Rica

RESUMEN

En este artículo se presenta el resultado del análisis de validez y confiabilidad de la Escala de Actitudes hacia la Tecnología en el Aprendizaje Escolar, aplicada a 504 niños y niñas de educación primaria pública en Costa Rica, cuyos centros educativos están adscritos al Programa Nacional de Informática Educativa (PRONIE) I y II Ciclos del Ministerio de Educación Pública y de la Fundación Omar Dengo. La escala inicial estuvo conformada por 62 ítemes divididos en nueve categorías. El tratamiento de la escala inició con un análisis de factores que permitió reordenar las categorías y desechar ítemes cuyas cargas factoriales eran inferiores a 0.40. Posteriormente se determinaron los coeficientes de correlación item-total cuyos valores fueron todos superiores o iguales a 0.30, y se terminó con un análisis de confiabilidad que arrojó un Alfa de Cronbach de 0.73 (0.46 en la dimensión 1 y 0.72 en la dimensión 2) para concluir que la escala final tiene buena consistencia interna. Finalmente, se construyó una nueva escala con 29 ítems agrupados en nueve categorías y dos dimensiones.

Palabras clave: Educación, Tecnología, Actitudes, Validez, Confiabilidad, Computadoras.

ABSTRACT

In this document, the results of the validity and reliability analysis of the constructed Attitudes toward Technology in Learning Primary School scale, are presented. Data were collected from 504 primary students of Costa Rican public schools which take part in the National Program of Educational Informatics for Primary Education, implemented by the Costa Rican Ministry of Public Education and the Omar Dengo Foundation. The scale was primarily composed of 62 items divided in nine categories. The analysis of the scale began with a factor analysis, that allowed the reorganization of the scale categories and the remove of items with factor loadings lower 0.40. Afterwards, correlation coefficients whose values were 0.30 or higher were estimated. The reliability analysis gave as result a Cronbach coefficient of 0.73 (0.46 in dimension 1 and 0.72 in dimension 2), leading to the conclusion that the scale is reliable. Finally, a new scale was constructed with 29 items, gathered in nine categories and two dimensions.

Keywords: Education, Technology, Attitudes, Validity, Confiability, Computers.

Introducción

El objetivo de la investigación en que se basa este artículo ha sido desarrollar una propuesta metodológica que permita evaluar el impacto social de proyectos educativos fundamentados en la utilización de las tecnologías de la información y la comunicación (TIC), desde la perspectiva de su contribución a la generación de condiciones de equidad.

Para el cumplimiento de este objetivo se elaboró, en primer lugar, un marco evaluativo de impacto social con perspectiva de equidad (Rodríguez, 2002), organizado por ámbitos y aspectos que permitieran clasificar un importante listado de indicadores, señalados en la literatura en este campo, y finalmente proceder con la construcción de estrategias que colaboraran con esa evaluación. Aquí se presenta el análisis de validez y confiabilidad para la depuración de la Escala de Actitudes hacia la Tecnología en el Aprendizaje Escolar (EATAE) creada para ser aplicada a niños y niñas de educación primaria pública en Costa Rica (ver Castro, 2003).

La EATAE que se utilizó fue construida a partir de diferentes consultas bibliográficas realizadas y por experiencias previas. En efecto, sabemos que la tecnología tiene una incidencia en la motivación de los y las estudiantes para asistir a la escuela. Asimismo los programas educativos que se fundamentan en el uso de las TIC tienen un impacto en la visión de futuro.

De acuerdo con Thurstone (1978) la actitud es La suma total de inclinaciones, sentimientos, prejuicios o distorsiones, nociones preconcebidas, ideas, temores, amenazas y convicciones de un individuo acerca de cualquier asunto específico (Thurstone, 1978, p. 158, como se cita en Castro, 2003). Las actitudes atraviesan la actividad humana y tienden a orientar los procesos perceptuales, cognitivos y emotivos implicados en el aprendizaje. De ahí la importancia de su estudio como parte de los factores que median en el impacto obtenido por programas educativos apoyados en TIC.

La revisión bibliográfica de Castro (2003) identifica una serie de aspectos importantes para evaluar actitudes hacia la tecnología en la educación, tales como los planteados por Lignan (1999, 2002); Mitra (2002), Franton, Green y Hoffman (2002) y Myint Swe Khine (2001). A estos aspectos se agregaron los identificados en estudios, obteniéndose el siguiente listado: valoración de la tecnología, motivación para asistir a la institución a partir de la introducción de las TIC, satisfacción con el programa o actividad, visión de futuro, planteamiento de metas de superación continuas, actitud para participar en grupos, sentido de control que se tiene sobre la tecnología, valoración del aprendizaje de la tecnología, valoración de la acción pedagógica, motivación para aprender, autorregulación de la relación con la tecnología, autonomía en la relación con la tecnología y aprendizaje de nuevas habilidades relacionadas con la tecnología. A partir de este conjunto se construyeron las categorías de la EATAE que se presentarán más adelante con sus respectivos ítemes.

Método

Participantes

La población a la cual se aplicó la escala, después de una prueba de campo para su depuración inicial, fue de 504 niños y niñas de primaria, cuyos centros educativos están inscritos en el PRONIE I y II Ciclos MEP-FOD, que asistieron al IX Congreso Nacional Infantil de Informática Educativa el 28 y 29 de marzo de 2003 en Santa Cruz, Guanacaste.

En el sentido anterior, se torna de suma importancia recalcar que la EATAE se aplicó a una población de niños y niñas que están habituados a relacionarse con la tecnología, específicamente en el uso de las computadoras, debido a que los centros educativos a los que acuden imparten la informática educativa. Dado que no se realizaron análisis estadísticos relacionados con la comparación con niños y niñas que asisten a escuelas que no están adscritas al PRONIE I y II Ciclos MEP-FOD, podría estarse presentando un sesgo importante de una actitud positiva hacia la relación con la tecnología, por las características de la población objetivo, con lo que la variabilidad de los ítemes podría verse afectada y, por ende, las correlaciones.

Para la prueba preliminar de campo esta escala se aplicó a 60 niños y niñas de dos centros educativos, uno suscrito al PRONIE I y II Ciclos MEP-FOD y otro que no.

Instrumento

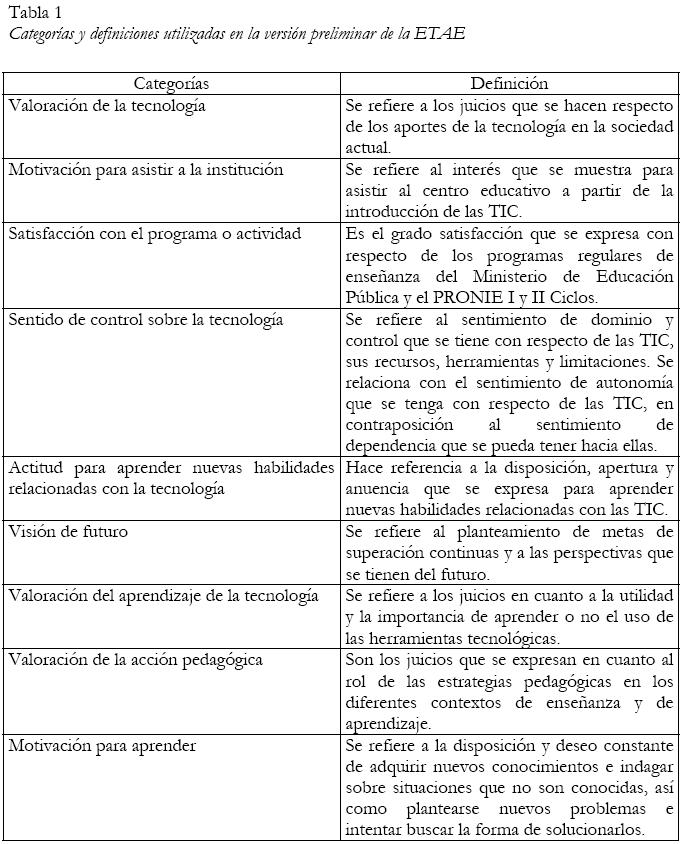

La EATAE1 de la que se partió para realizar la prueba de campo inicial y posteriormente su primera depuración, estuvo conformada por 62 ítemes distribuidos en nueve categorías. Esta selección de ítemes tiene su fundamento en la investigación bibliográfica realizada por Castro (2003) para la construcción de un listado de indicadores (Rodríguez, 2002) que facilitara la creación de los diferentes instrumentos de evaluación en cada uno de los ámbitos que componen el marco evaluativo. La definición de cada una de las nueve categorías que componían la escala es la siguiente:

Después de sostener algunas discusiones dentro el equipo de investigación y de realizar varias consultas a profesionales con experiencia en el campo, se concluyó que utilizar una escala para degradar las posibles respuestas a los ítemes (Escala de Likert) podría producir confusiones en los niños y las niñas y ocasionar que las diferencias en las respuestas no se debieran al azar sino a un mal entendimiento de las afirmaciones (ítemes) que se les planteaban. Debido a que la escala se aplicaría a niños y niñas de educación primaria, cuyas edades generalmente oscilan entre los 7 y los 12 años, cada uno de los ítemes representó una variable dicotómica cuyas posibles respuestas fueron sí o no. Para los efectos del análisis de la EATAE, se prescindirá de la presentación de las categorías e ítemes que conformaban la versión preliminar de la escala, dado que al final se incluirá la versión final sugerida después de realizar los análisis respectivos.

Procedimientos de aplicación

La escala, después de la primera depuración, quedó conformada por 45 ítemes distribuidos en las mismas nueve categorías.

Para validar la escala en su segunda versión se hizo necesario aplicarla como mínimo a una cantidad de individuos igual a cinco veces el número de ítemes con el objetivo de evitar obtener correlaciones espuriamente altas, que pueden aparecer cuando el número de ítemes y el de individuos que responde la prueba son semejantes. La cantidad mínima de niños y niñas a los que debía administrarse el instrumento tenía que ser de 225.

Como ya se ha mencionado, la escala se aplicó a 504 niños y niñas asistentes al IX Congreso Nacional Infantil de Informática Educativa, que se desarrolló en Santa Cruz, Guanacaste, al norte de Costa Rica, los días 28 y 29 de marzo de 2003. Al igual que para la prueba preliminar, los datos fueron ingresados en el SIMAE y la sistematización y las pruebas se realizaron con el SPSS.

Procedimientos de análisis

El análisis que se ha aplicado para la depuración final de la EATAE tiene su fundamento en tres pruebas estadísticas. La primera de ellas es el análisis de factores que consiste en identificar variables subyacentes, o factores, que expliquen la configuración de las correlaciones dentro del conjunto de variables observadas. El análisis de factores se suele utilizar en la reducción o simplificación de datos para identificar un pequeño número de factores que explique la mayoría de la varianza observada en un número mayor de variables manifiestas.

Para el caso de la EATAE, este método estadístico permite precisar el número y naturaleza de los ítemes que forman una determinada categoría. Debe recordarse que las categorías fueron construidas previamente para desglosar el objeto de estudio. Con este análisis se generan variables artificiales, conocidas también como variables latentes o dimensiones, (categorías compuestas por ítemes) que representan los factores. Los factores se obtienen de los ítemes originales y se interpretan de acuerdo con el significado de las categorías. En resumen, ...es una técnica para explicar un fenómeno complejo en función de un determinado grupo de variables. (Hernández, Fernández y Baptista, 2000, p. 414).

Debido a que, como se mencionó, las categorías de la escala (con sus respectivos ítemes) fueron construidas previamente desde la teoría presentada por diversos autores y desde las hipótesis de los investigadores, el análisis de factores permite validar esa construcción. Anastasi y Urbina (1998) mencionan, al respecto de la validez de los constructos y la contribución particular del análisis factorial a esa validación, lo siguiente:

La validez de constructo de un instrumento es el grado en el que puede afirmarse que mide un constructo o rasgo teórico. La validación de constructo requiere de la acumulación gradual de diversas fuentes de información; cada constructo se deriva de las interrelaciones entre medidas conductuales y se forma para organizar y dar cuenta de las concordancias observadas en la respuesta (...). Desarrollado como un medio para identificar rasgos psicológicos, el análisis factorial es particularmente relevante para los procedimientos de validación del constructo. En el proceso de análisis factorial, se reduce el número de variables o categorías en cuyos términos puede describirse el desempeño de cada individuo a un número relativamente pequeño de factores o rasgos comunes (Anastasi y Urbina, 1998, pp. 126-128).

Por lo tanto, de acuerdo con las autoras anteriores, el análisis de factores proporciona una medida de la homogeneidad no solo de la totalidad de ítemes que conforman la escala sino del grupo de ítemes que se registran dentro de una categoría. Además, a través de la medición de esa homogeneidad se puede determinar si los ítemes explican el comportamiento de esa categoría y si alguno debería estar adscrito a otra categoría y no a la que pertenece originalmente.

La prueba cumple su cometido cuando se analizan las cargas factoriales de los ítemes de cada una de las categorías. Se ha determinado con la teoría y a través de la práctica, que cargas factoriales inferiores a 0.4 (pueden variar entre –1 y +1) generan una muy baja correlación ítem-total, de ahí que deban desecharse para aumentar la confiabilidad de la escala.

La segunda prueba está relacionada con el análisis de la correlación de todos los ítemes de la escala en cada una de las categorías de pertenencia. Para realizarla se utilizó el Coeficiente de Correlación Producto-Momento de Pearson (correlación ítem-total). Este coeficiente indica la magnitud y la dirección de la relación entre los ítemes con sus categorías y proporciona una medida de la fuerza de esa relación. Su valor puede oscilar entre –1 y +1. El valor –1 significa que hay una correlación negativa perfecta (conforme aumenta el puntaje de un ítem, el de la categoría disminuye); 0 quiere decir que no existe correlación alguna y +1 indica una correlación positiva perfecta entre los ítemes y sus categorías (conforme uno aumenta su puntaje, la categoría también).

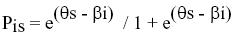

Los coeficientes de correlación que arrojan valores inferiores a 0.30 generalmente deben ser desechados o reformulados, no solo porque producen una disminución de la confiablidad total de la escala sino porque correlaciones a partir de 0.30 en general son estadísticamente significativas más allá del nivel del 1% (Cohen y Manion, 1990). La otra explicación que existe para desechar los ítemes con coeficientes de correlación inferiores a 0.30 (debido a que se puede esperar significancias en coeficientes inferiores a ese valor), es que con el coeficiente de correlación se calcula el Coeficiente de Determinación (π) que explica el porcentaje de la variabilidad de un ítem con respecto del otro. La fórmula que se aplica es la siguiente:

Con coeficientes de correlación inferiores a 0.30, los coeficientes de determinación serán inferiores o iguales al 9%, con lo que no se estaría explicando ni siquiera el 10% de la variabilidad de un ítem en comparación con el otro. Una baja correlación entre los ítemes comparados y el puntaje total puede deberse a diversas causas, ya sea de mala redacción del ítem o que no funciona para medir lo que se desea, de ahí que la depuración de los ítemes tiene como consecuencia aumentar la fiabilidad de la escala.

Finalmente, la tercera prueba consiste en realizar un análisis de fiabilidad que permite estudiar las propiedades de las escalas de medición y de los ítemes que las constituyen. La medida de la confiabilidad puede estimarse a través del coeficiente Alfa de Cronbach. La ventaja de este coeficiente reside en que requiere una sola administración del instrumento de medición y puede tomar valores entre 0 y 1, donde 0 significa nula confiabilidad y 1 representa la confiabilidad total. La teoría ha venido considerando que un Alfa de Cronbach igual o superior a 0.70 tiene una buena confiabilidad interna, tanto mejor cuanto más se acerque a 1 (Cohen y Manion, 1990). El procedimiento permite calcular el Alfa de Cronbach para toda la escala y presenta el valor del coeficiente si el ítem es desechado, lo que ayuda a visualizar nuevos ítemes que no habían sido retirados con base en las dos pruebas anteriores, con el objetivo de aumentar la confiablidad de la escala.

El programa que se utilizó para ingresar los datos al computador fue el Sistema Integrado de Manejo de Encuestas (SIMAE). Este programa facilita la digitación haciendo pases automáticos y controlando códigos fuera de rango. Además, puede generar listados de cuestionarios digitados, borrarlos y corregir variables, entre otras funciones. Los valores que se asignaron a las respuestas dicotómicas de los ítemes fueron: 1 = Sí y 0 = No. Finalmente, los análisis y las pruebas estadísticas se realizaron con el Statistical Package for Social Sciences (SPSS).

Resultados

El objetivo de aplicar la escala a un grupo de niños y de niñas, antes de hacer la prueba para la metodología desarrollada, no es solo corroborar la redacción y el entendimiento de los ítemes sino tratar de reducir la cantidad de ítemes que contenía la escala.

Con respecto a la redacción y al entendimiento de los ítemes, se comprobó que ninguna de las afirmaciones producía problema. El análisis para determinar cuáles ítemes podrían excluirse de la escala se hizo con la aplicación de dos procesos. El primero de ellos consistió en identificar ítemes que presentaban una variablidad nula (varianza cero), es decir aquellos para los cuales el coeficiente de correlación no se podía obtener debido a que las respuestas de los niños y las niñas eran constantes (todas sí o todas no). Doce ítemes presentaron esta particularidad aunque, debido a los objetivos del estudio y de la escala, cuatro de ellos se dejaron para administrar nuevamente la prueba una mayor cantidad de niños y niñas.

Tomando como base la organización de ítemes y categorías que se presentó en el apartado precedente, los ítemes en la condición anterior se presentan en la siguiente tabla:

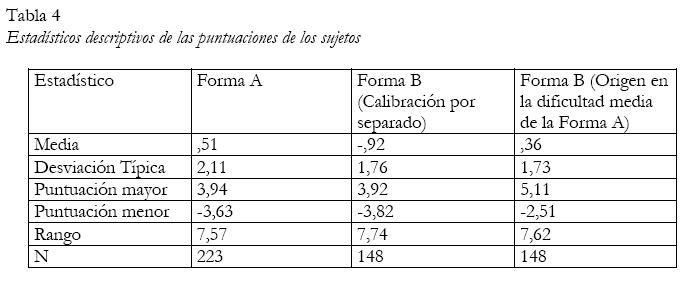

Posteriormente se obtuvo el coeficiente de correlación de todos los ítemes restantes y, con base en éste, se calculó el coeficiente de determinación para tener la medida del porcentaje en que cada ítem explicaba la variabilidad de la categoría a la que pertenecía. Los ítemes que decidieron dejarse en la escala fueron aquellos que explicaban al menos el 40% de la variablidad de la categoría. Debe recordarse que el proceso de depuración de la EATAE fue realizado en diferentes fases. En su primera versión, la escala estuvo conformada por 62 ítemes y fue probada con 60 niños y niñas de dos centros educativos. Con la información recolectada de esta prueba se tomó la decisión de seleccionar aquellos ítemes que registraran al menos una proporción del 40% de la varianza explicada. Una vez que la escala fue depurada con base en los primeros análisis y aplicada a los 504 niños y niñas, se tomó como criterio una correlación de al menos 0.30, tal y como se consigna en los cuadros y en los resultados para la determinación de la EATAE final. La conformación de la escala puede observarse en el Apéndice 1 (Tabla 4).

Análisis de factores

Para realizar este proceso la escala fue sometida a un análisis de componentes principales con rotación VARIMAX en dos momentos diferentes. Para el primero se obtuvo el Diagrama de Sedimentación para determinar si las categorías construidas de previo agrupaban la mayor cantidad de ítemes posible, de manera que el análisis posterior permitiera limitar a 9 el número de categorías (o factores) involucradas.

Este análisis preliminar permitió comprobar que varios de los ítemes tenían cargas factoriales en categorías a las que no pertenecían originalmente. Este hecho indicaba que muy probablemente el conjunto de categorías no podría tomarse en su totalidad para realizar el análisis de factores, sino que era necesario dividirlas en subgrupos para analizar las cargas factoriales según su lógica de medición y de pertenencia a una determinada temática. Si bien es cierto todos los ítemes están relacionados con la tecnología, se pueden identificar dos dimensiones:

Dimensión 1: Categorías relacionadas con la medición en torno al tema de la tecnología (18 ítemes)

- Valoración de la tecnología

- Sentido de control sobre la tecnología

- Valoración del aprendizaje de la tecnología

- Actitud para aprender nuevas habilidades relacionadas con la tecnología Dimensión 2: Categorías relacionadas con la medición en torno a los temas de enseñanza y aprendizaje (27 ítemes)

- Motivación para asistir a la institución

- Satisfacción con el programa o actividad

- Visión de futuro

- Valoración de la acción pedagógica

- Motivación para aprender

Dimensión 1

Para este primer grupo el Diagrama de Sedimentación de los ítemes corroboró que la mayoría de estos podían ubicarse en cuatro categorías, aunque los resultados arrojaron que algunos deberían estar ubicados en otras categorías y no necesariamente en las de partida. La selección final de los ítemes por categoría que puntuaron como mínimo 0.40 se muestran en el siguiente cuadro.

Según los cálculos obtenidos el primer factor, con un valor propio de 1.80, explica el 11.28% de la varianza de los ítemes y por su tipo se le ha denominado Actitud para aprender nuevas habilidades relacionadas con la tecnología. El segundo factor explica el 10.82% de la varianza de las respuestas y tiene un valor propio de 1.73 y, debido a la mayoría de las afirmaciones que lo conforman se le ha cambiado el nombre a Valoración del aprendizaje de la tecnología. El tercer factor tiene un valor propio de 1.65, explica el 10.31% de la variablidad de sus ítemes y, debido a esta conformación, ha sido llamado Valoración del uso de la tecnología. Finalmente, el cuarto factor explica el 8.87% de la variabilidad y posee un valor propio de 1.41; debido a las frases que lo conforman se ha nombrado como Actitud frente a la tecnología.

Dimensión 2

El Diagrama de Sedimentación para este grupo también mostró una clara agrupación de la mayoría de los ítemes alrededor de las cinco categorías definidas. La selección de los ítemes con carga factorial mayor 0.4 se describen en el Cuadro 2.

Como se puede observar muchos de los ítemes han quedado concentrados alrededor del factor 1 que ha mantenido su nombre (Motivación para asistir a la institución); este factor tiene un valor propio de 3.87 y explica el 15.47% de la variabilidad de sus ítemes. El factor 2 tiene un 7.36% de varianza explicada y posee un valor propio de 1.84, agrupando ítemes en la nueva categoría denominada Satisfacción con las actividades del programa. La categoría Visión de futuro (factor 3) mantuvo su nombre, tiene un valor propio de 1.80 y explica el 7.18% de la varianza de las respuestas. El factor 4, debido a sus nuevos ítemes, se ha llamado Motivación para aprender, explica en un 6.60% la varianza de las afirmaciones y posee un valor propio de 1.65. El último factor tiene un valor propio de 1.55 y una varianza explicada de 6.19%; el nombre que se le ha asignado a esta categoría es Actitud frente a la continuación de los estudios.

En la tabla siguiente se presenta, para ambas dimensiones, los antiguos y nuevos nombres de las categorías que las conforman.

El análisis de factores permitió concluir dos aspectos importantes:

a. Fue necesario dividir la EATAE en dos dimensiones para que los ítemes tuvieran cargas factoriales mejor distribuidas según la categoría a la que pertenecían y a la dimensión en que estaba inscrita esta categoría.

b. De 45 ítemes resultantes de la primera depuración de la escala se experimentó una nueva reducción (30 ítemes) al excluir todas aquellas afirmaciones cuyas cargas factores eran inferiores a 0.40.

Determinación de los coeficientes de correlación.

Una de las ventajas de reacomodar los ítemes en las categorías como consecuencia del análisis de factores es que se obtiene una buena correlación ítem-total. Los Cuadros 3 y 4 muestran los valores de los coeficientes de correlación para cada uno de los ítemes con respecto a sus categorías de pertenencia en cada una de las dos dimensiones.

Todas las correlaciones de los ítemes con sus categorías respectivas fueron mayores a 0.30, con lo que se garantiza que la menos un 10% de la variabilidad se explica por las categorías con que fueron relacionados. El único que fue inferior a ese valor fue Puedo aprender muchas cosas si sé usar una computadora de la categoría Valoración del uso de la tecnología de la Dimensión 1 cuya correlación fue de 0.23. Además, todos los resultados de las correlaciones fueron significativas al 1%. Por otro lado, es importante obtener la correlación de las categorías en relación con la dimensión a la que pertenecen, de manera que se pueda determinar el porcentaje de explicación de la variabilidad de las dimensiones con sus categorías. Este resumen se obtuvo sumando los puntajes obtenidos en cada uno de los ítemes para una categoría específica y dividiéndolo entre la totalidad de ítemes en el factor. En el Cuadro 5 se resume esta información.

Todas las correlaciones de las categorías con sus respectivas dimensiones fueron significativas al 1% y la mayoría fueron mayores a 0.30, con excepción de Valoración del aprendizaje de la tecnología (0.19) de la Dimensión 1 y satisfacción con las actividades del programa (0.24) de la Dimensión 2.

Si bien es cierto con el procedimiento se recomendaría eliminar estas dos categorías debido a la baja correlación, un examen de los ítemes que las conforman brinda la posibilidad de mantenerlas en la escala, debido a las altas correlaciones significativas al 1% obtenidas de estos ítemes con respecto de sus categorías de pertenencia.

El procedimiento que se aplicó para obtener las correlaciones de las categorías con sus respectivas dimensiones también se empleó para calcular las correlaciones de las dimensiones con respecto de la escala total. En este aspecto también se obtuvieron correlaciones significativas al 1% y mayores a 0.30 (0.90 en la Dimensión 1 y 0.71 en la Dimensión 2). Finalmente, la correlación entre las dos dimensiones es de 0.32 (significativa al 1%).

Con el análisis de los coeficientes de relación se obtuvieron 11 ítemes involucrados en la Dimensión 1 y 18 en la Dimensión 2, divididos en 4 y 5 categorías respectivamente.

Análisis de confiabilidad

Por lo general, si en el análisis de confiabilidad se obtienen Alfas mayores o iguales a 0.70 y coeficientes de correlación mayores o iguales a 0.30 se puede concluir que hay una buena consistencia interna de la escala.

Dado que el análisis de factores arrojó resultados en torno a dos dimensiones, para el análisis de fiabilidad se introdujeron los ítemes correspondientes a cada una de las dimensiones por separado. En el caso de la Dimensión 1 si bien es cierto los coeficientes de correlación varían entre 0.56 y 0.90, el Alfa de Cronbach fue de 0.47. Por otro lado, se debe recordar que este valor también depende no solo de la variabilidad que presenten los ítemes sino de su cantidad. Los coeficientes de correlación en la Dimensión 2 varían entre 0.53 y 0.94 y el Alfa de Cronbach obtenido fue de 0.73.

Sin embargo, al obtenerse una correlación de 0.32 (significativa al 1%) entre las dos dimensiones se puede concluir que se encuentran relacionadas, de manera que se ingresaron los 29 ítemes como si pertenecieran a una sola dimensión. En este caso el Alfa de Cronbach que se obtuvo fue de 0.73, lo que define, conjuntamente con los coeficientes de correlación, una consistencia interna aceptable de la escala.

Si bien es cierto se solicitó el cálculo de los Alfas si los ítemes eran borrados de la escala, tanto para las dimensiones individuales como para la escala total, el retiro de alguno no producía variaciones importantes (de incremento) en el Alfa de Cronbach.

La conformación de la escala final

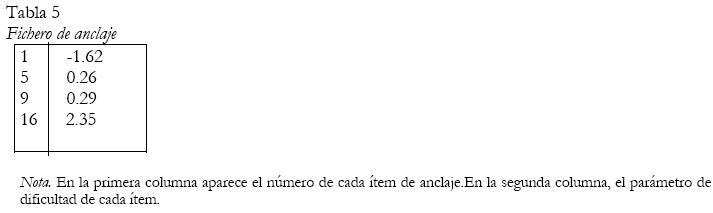

La siguiente es la propuesta final de la Escala de Actitudes hacia la Tecnología en el Aprendizaje Escolar, una vez que se determinaron los ítemes que arrojaban una carga factorial superior o igual a 0.4, los coeficientes de correlación fueron todos mayores o iguales a 0.30 (donde todas las correlaciones resultaron significativas al 1%) y cuyo análisis de confiabilidad dio como resultado un Alfa de Cronbach de 0.73. La conformación de la EATAE final puede observarse en el Apéndice 2 (Tabla 5).

Discusión

La validez y la confiabilidad son dos conceptos de suma importancia en la aplicación de una escala, cualquiera que sea el tema.

Cuando se construye una escala conformada por categorías cuya definición fue previa a su aplicación, la validez y la confiabilidad permiten determinar la homogeneidad de los constructos y cuán confiable puede ser la escala para medir lo que se desea medir.

En el caso de la Escala de Actitudes hacia la Tecnología en el Aprendizaje Escolar, este análisis estableció, por las cargas factoriales de los ítemes que conformaban las categorías iniciales, que era necesario desechar ítemes que no estaban aportando a la homogeneidad, reacomodar algunos que puntuaban más alto en relación con otros que pertenecían a categorías distintas y construir dos grandes grupos de categorías que se relacionaran temáticamente y que aumentaran la confiabilidad de la escala.

Por otro lado, el reacomodo de los ítemes en otras categorías sugirió, a través del análisis de las diferentes afirmaciones que las conformaban, que era necesario cambiarles el nombre para que sus ejes temáticos se vieran enriquecidos por el nuevo acomodo. Además, se garantizó que las correlaciones fueran altas y significativas.

Las pruebas relacionadas con el análisis de factores y el cálculo de los coeficientes de correlación confluyeron en la obtención de un Alfa de Cronbach de 0.73, lo que asegura una consistencia interna aceptable de la escala. Sin embargo, el bajo coeficiente obtenido en la Dimensión 1 (0.47) indica que es necesario someter la escala a un proceso de revisión (en esta dimensión particular) y proceder con un nuevo análisis de validez y confiabilidad no solo para la dimensión misma sino en relación con la Dimensión 2 y la escala total.

De 62 ítemes distribuidos en nueve categorías, se obtuvo al final una escala con 29 ítemes distribuidos en nueve categorías y éstas en dos dimensiones.

Se ha presentado un análisis exhaustivo a nivel de confiabilidad. Sin embargo, es importante recordar que el análisis de factores es exploratorio, es decir, depende en gran parte de las respuestas de las personas y no solo de la teoría que sustenta la construcción de una escala, por lo que se podría concluir que este análisis debe complementarse con otros criterios para comprobar la validez de una escala, tales como criterios de validez convergente (la escala correlaciona con otras que miden constructos parecidos), validez discriminante (la escala no correlaciona con otras que miden temas distintos) o validez predictiva (puede predecir la escala, por ejemplo, el rendimiento de los niños y las niñas en los cursos relacionados con la tecnología).

Referencias

Amón, J. (1993). Estadística para psicólogos 2. Madrid: Pirámide. [ Links ]

Anastasi, A. & Urbina, S. (1998). Tests psicológicos. México: Prentice Hill. [ Links ]

Castro, R. (2003). Actitudes de docentes y estudiantes hacia la tecnología en la educación y el aprendizaje: una evaluación comparativa entre beneficiados y no beneficiados del Programa Nacional de Informática Educativa para I y II Ciclos MEP-FOD. Documento de trabajo. San José Costa Rica: Departamento de Investigación, Fundación Omar Dengo. [ Links ]

Cohen, L & Manion, L. (1990). Métodos de investigación educativa. España: La Muralla. [ Links ]

Franton, C., Green, K. & Hoffman, E. (2002). Measure development: The childrens attitudes toward technology scale (CATS). Journal of Educational Computing Research, 26, 3, 249-263. [ Links ]

Hernández, R. et al. (2000). Metodología de la investigación. México: Mc Graw Hill. [ Links ]

Lignan, L. (2002). Actitudes de los alumnos y maestros hacia la computadora y los medios para el aprendizaje. Recuperado el 9 octubre de 2002, de: http://investigacion.ilce.edu.mx/dice/proyectos/actitudes/actit9.htm. [ Links ]

Lignan, L. (2002). Validación del cuestionario sobre las actitudes de los maestros hacia la computadora. Documentos de la Sociedad Mexicana de Computación, México. Recuperado el 27 de febrero de 2003, de http://www.te.ipn.mx/files/f000504/txt.docto.htm. [ Links ]

Mitra, A. (2002). Toward developing questionnaire items to measure effectiveness of computers in teaching. Journal of Educational Computing Research, 26, 4, 381-394. [ Links ]

Myint Swe, K. (2001). Attitudes toward computers among teachers education students in Brunei Darussalam. International Journal of Instructional Media, 28, 2, 147. [ Links ]

Rodríguez, J. (2002). Marco evaluativo de impacto social con perspectiva de equidad para programas educativos mediados por TIC. Documento de trabajo. San José. Costa Rica: Departamento de Investigación, Fundación Omar Dengo. [ Links ]

Steel, R. y Torri, J. (1986). Bioestadística. Principios y procedimientos. México: Mc Graw Hill. [ Links ]

Artículo recibido: 26-5-2003

Aceptado: 20-10-2003

*Dirección postal: 86-3000, Heredia, Costa Rica. Ce: rvarga@una.ac.cr

1Los ítemes y las categorías de esta escala fueron desarrollados por Ricardo Castro Castro (2002-2003), asistente de investigación del Departamento de Investigación de la Fundación Omar Dengo, bajo la supervisión de José Miguel Rodríguez García (coordinador general de la investigación) y Magaly Zúñiga Céspedes (directora del proyecto y del Departamento de Investigación).

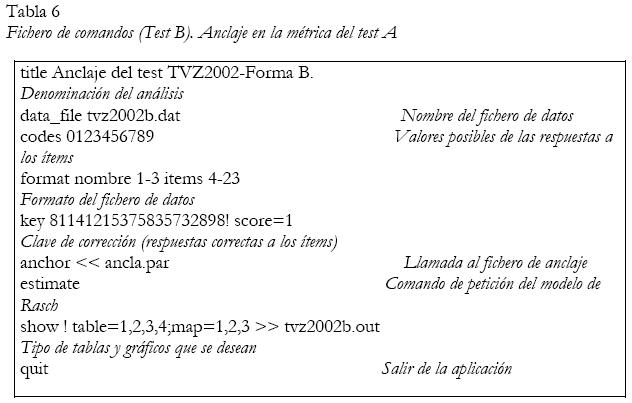

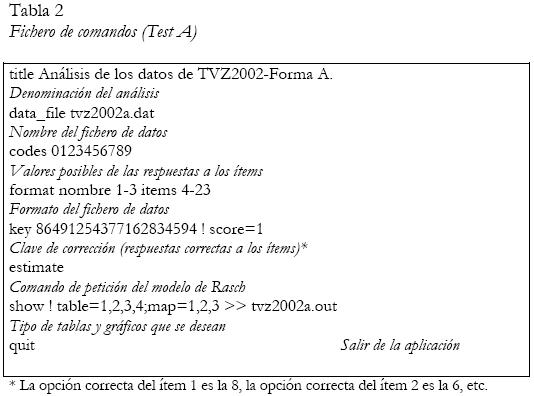

Apéndice 1

Apéndice 2