Services on Demand

article

Indicators

Share

Acta Comportamentalia

Print version ISSN 0188-8145

Acta comport. vol.20 no.1 Guadalajara 2012

Artículo

La adquisición de presionar la palanca en ratas bajo condiciones degradadas de reforzamiento condicionado

The acquisition of lever-pressing by rats under degraded conditions of conditioned reinforcement

Karina A. Bermúdez; Carlos A. Bruner1

Universidad Nacional Autónoma de México, Laboratorio de Condicionamiento Operante de la Facultad de Psicología (México)

Resumen

Existen pocos estudios sobre la adquisición de nuevas respuestas bajo condiciones degradadas de reforzamiento condicionado. En este trabajo se estudió la adquisición y el posterior mantenimiento de una nueva respuesta con 21 ratas expuestas directamente a un programa constante intervalo al azar 7.5 s para obtener un estímulo de 1 s por presionar una palanca. Concurrentemente el mismo estímulo y una bolita de comida se presentaron independientemente de la respuesta a través de las sesiones de 32 minutos conforme a un programa tiempo fijo 64 s. Para cada tres ratas, la separación entre el estímulo y la comida fue de 0, 1, 2, 4, 8, 16 o 32 s en bloques consecutivos de 40 sesiones. Aunque con tasas bajas todas las ratas presionaron la palanca aún con intervalos entre el estímulo y la comida tan largos como 32 s. Las tasas de respuesta fueron progresivamente más bajas conforme se alargó el intervalo entre el estímulo y la comida a la manera de un gradiente de eficacia del reforzador condicionado. Este hallazgo es nuevo en la literatura sobre la adquisición de nuevas respuestas con reforzamiento condicionado.

Palabras clave: adquisición de la respuesta, reforzamiento condicionado, ratas, presión a la palanca, intervalo estimulo-comida.

Abstract

There are few studies on the acquisition of new responses under degraded conditions of conditioned reinforcement. In this investigation the establishment and subsequent maintenance of a new response was studied with 21 rats directly exposed to a constant random-interval 7.5 s schedule for a 1-s light stimulus for leverpressing. Concurrently, the same stimulus and one food pellet were delivered independently of responding across the entire 32-minute sessions on a fixed-time 64 s schedule. For three rats each the stimulus and the delivery of food were separated by intervals of either 0, 1, 2, 4, 8, 16, or 32 s over consecutive blocks of 40 sessions. Although at low rates all rats lever-pressed even with intervals between the stimulus and food as long as 32 s. Response rates were progressively lower as the stimulus-food interval was lengthened, resembling a gradient of efficacy of conditioned reinforcement. Such finding is new to the literature on the acquisition of new responses with conditioned reinforcement.

Key words: acquisition, conditioned reinforcement, rats, lever-pressing, conditioned-primary reinforcement intervals.

El establecimiento de nuevas respuestas fue el tema favorito de los teóricos del aprendizaje (e.g., Guthrie, 1935; Hull, 1943; Tolman, 1932). Sin embargo, la diversidad en las situaciones experimentales que emplearon (e.g., laberintos, callejones, cajas de truco, etc.) así como sus diferentes variables dependientes (e.g., el número de ensayos exitosos, la latencia de la respuesta, el número de respuestas para alcanzar un criterio, etc.) dificultaban la comparación de sus resultados entre si. También dificultaban cualquier comparación con los que se podrían obtener usando la entonces crecientemente popular operante libre. Por esta razón, estudios posteriores que empleaban la operante libre relegaron el estudio del establecimiento de nuevas respuestas a un plano secundario, enfatizando el mantenimiento de conductas ya establecidas. Si acaso, el estudio de la adquisición de nuevas respuestas como operantes libres se limitó a desarrollar técnicas, tales como el entrenamiento a acercarse al comedero y el moldeamiento de la respuesta para asegurar que la respuesta de interés ocurriera en el menor tiempo posible (Catania, 1979; Ferster, 1953). Bajo estas circunstancias, un estudio realizado por Lattal y Gleeson (1990) reanimó el interés por el estudio de la adquisición de nuevas respuestas usando la operante libre. Estos investigadores reportaron el establecimiento de picar una tecla en palomas y presionar una palanca en ratas exponiéndolas directamente a reforzamiento primario (comida) intermitente y además demorado. Sus resultados desafiaron la sabiduría convencional que abogaba por habituar a los sujetos a la cámara experimental, moldear la respuesta reforzando aproximaciones sucesivas a la respuesta meta y posteriormente reforzar la respuesta meta inmediata y continuamente. En investigaciones posteriores se amplió el conocimiento sobre la adquisición de nuevas respuestas con reforzamiento demorado e intermitente usando operantes libres con otras topografías de respuesta, diferentes especies y otras situaciones experimentales (Anderson & Elcoro, 2007; Critchfield & Lattal, 1993; Galuzka & Woods, 2005; Lattal & Glesson, 1990; Lattal & Metzger, 1994; Sutphin, Byrne, & Poling, 1998).

El estudio de la adquisición de nuevas respuestas bajo condiciones degradadas de reforzamiento primario (i.e., intermitente y demorado) en situaciones de operante libre es importante por diversas razones, pero principalmente porque permite comprender la forma como los organismos en sus escenarios naturales enriquecen su repertorio conductual aún en circunstancias que no se considerarían como óptimas. Dado que el reforzamiento primario en escenarios naturales debe ser menos abundante que el reforzamiento condicionado, surge el interés por estudiar el mismo fenómeno bajo circunstancias degradadas de reforzamiento condicionado. Hasta la fecha, la adquisición de nuevas respuestas con reforzamiento condicionado ha sido poco estudiada. Un antecedente importante es el experimento hecho por Skinner (1938) en el que utilizó la "técnica de la nueva respuesta" con ratas. Esta técnica consiste en primero operar el dispensador de comida independientemente de la conducta de los sujetos, de tal forma que al acompañar la entrega de comida, el sonido del dispensador adquiere la función de un reforzador condicionado. Posteriormente el sonido del dispensador vacío puede usarse como el reforzador de una nueva respuesta, como presionar una palanca. Tanto en el estudio de Skinner como en otros posteriores se mostró que la "técnica de la nueva respuesta" resulta confiablemente en el establecimiento de nuevas conductas con reforzamiento condicionado (Bersh, 1951; Butter & Thomas, 1958; Fox & King, 1961; D. Zimmerman, 1957).

A pesar de que la "técnica de la nueva respuesta" es un procedimiento útil para mostrar la capacidad del reforzamiento condicionado para establecer una nueva conducta, tiene la desventaja de que la presentación aislada (en ausencia de comida) del reforzador condicionado resulta en el decaimiento de su eficacia como reforzador a través del tiempo (cf. Gollub, 1977). Un procedimiento que ofrece una solución al problema de la pérdida gradual de la función del reforzador condicionado es el diseñado por Zimmerman y Hanford (1966) usando palomas como sujetos. El procedimiento consiste en continuar apareando el estímulo con la función de reforzador condicionado (que puede ser el sonido del dispensador de comida o cualquier otro evento) con el reforzador primario, independientemente de la conducta de los sujetos durante toda la sesión. Concurrentemente, el picar una sola tecla tiene como única consecuencia producir el reforzador condicionado.

La característica distintiva del procedimiento de Zimmerman y Hanford (1966) es mantener constante el apareamiento del estímulo con el reforzador primario al mismo tiempo que el estímulo previamente neutral se emplea para reforzar la respuesta que lo produce. Por esta razón, Villegas, Bruner, y Hernández (2009) adaptaron el procedimiento diseñado por Zimmerman y Hanford para estudiar algunos parámetros de la adquisición de la respuesta de presionar una palanca en ratas con reforzamiento condicionado. Con base en la familiaridad de los autores con valores de las variables efectivas con ratas, los apareamientos del estímulo (un cambio en la iluminación de la cámara experimental por 1 s) con el reforzamiento primario (una bolita de comida) se presentaron con un programa tiempo al azar (TA) 30, 60 o 120 s. La presentación del estímulo ocurrió contingente a la presión a una palanca con un programa intervalo al azar (IA) 7.5, 15 o 30 s. Los valores de los programas se combinaron mediante un diseño factorial 3 (valores del TA) x 3 (valores del IA) y se expuso a tres ratas diferentes sin experiencia directamente a cada combinación de variables. Villegas et al. encontraron adquisición de la respuesta en todos los sujetos. La tasa de respuesta fue más alta en aquellas combinaciones de valores cortos de ambos programas que en combinaciones de valores más largos.

En el experimento de Villegas et al. (2009) se estudió el establecimiento y el posterior mantenimiento de presionar una palanca en ratas manteniendo constante la presentación incondicional del estímulo en una relación de contigüidad temporal con el reforzador el primario. El consenso de la literatura sobre las condiciones suficientes para dotar a un estímulo con la función de un reforzador condicionado indica que depende de su contigüidad temporal con el reforzador primario (cf. Kelleher & Gollub, 1962; Keller & Schoenfeld, 1950; Kimble, 1961). El propósito del presente estudio fue utilizar el procedimiento de Villegas et al. para observar la adquisición y el posterior mantenimiento de la respuesta de presionar una palanca en ratas con reforzamiento condicionado mientras se introducen intervalos cada vez más largos entre el estímulo y el reforzador primario. El estudio de la adquisición de nuevas respuestas bajo condiciones degradadas de reforzamiento primario, como es el reforzamiento intermitente y demorado (e.g., Lattal & Gleeson, 1990) ha contribuido al conocimiento de los valores límites de las variables involucradas que aún permiten la ocurrencia del fenómeno. El presente estudio sigue el tema de investigación de la adquisición de nuevas respuestas bajo condiciones degradadas de reforzamiento, pero usando reforzamiento condicionado. En esta investigación se dio el primer paso en esta dirección degradando la condición óptima para el reforzamiento condicionado; i.e., la contigüidad entre el estímulo y el reforzador primario.

Método

Sujetos

Se utilizaron 21 ratas Wistar macho experimentalmente ingenuas de tres meses de edad al inicio del experimento. A lo largo de todo el experimento las ratas se mantuvieron en cajas habitación individuales con acceso libre al agua y se les controló diariamente la comida para mantenerlas al 80% de su peso ad libitum.

Aparatos

Se utilizaron seis cámaras experimentales (MED Associates Inc.® Modelo ENV-001) equipadas con un comedero de metal al centro del panel frontal (Modelo ENV-200R1M) conectado a un dispensador de bolitas de comida (Modelo ENV-203). Las bolitas de comida, de 25 mg se elaboraron remoldeando comida para rata pulverizada (Rodent Laboratory Chow 5001 de Purina México®). En cada caja había una palanca al lado derecho del comedero (Modelo ENV-110RM). El interruptor de la palanca operó con una fuerza mínima de 0.15 N. Las cámaras experimentales estuvieron iluminadas con un foco ubicado en la parte posterior de cada cámara (Modelo ENV-215M). En cada caja hubo una luz ubicada arriba de la palanca (Modelo ENV-221M). Cada cámara experimental estuvo en el interior de un cubículo sonoamortiguado (Modelo ENV-022SM) equipado con un generador de ruido blanco (Modelo ENV-225SM) para enmascarar ruidos ajenos a la investigación y un ventilador que sirvió para facilitar la circulación del aire. Los eventos experimentales se controlaron por medio de una interfase (Modelo SG-503) conectada a una computadora equipada con software MED-PC® IV, ubicada en un cuarto adyacente a aquel en donde estuvieron las cámaras experimentales.

Procedimiento

Sin ningún entrenamiento preliminar se expuso a los sujetos directamente a un programa IA 7.5 s (t = 1.85 s, p =.25) para obtener un estímulo presionando la palanca. Este programa se mantuvo constante durante todo el experimento. El estímulo por adquirir la función de un reforzador condicionado consistió en el apagado de la luz general de la cámara experimental y el encendido de una luz ubicada encima de la palanca durante 1 s. Concurrentemente, el estímulo y el reforzador primario (comida) se presentaron independientemente de la conducta durante toda la sesión conforme a un programa tiempo fijo (TF) 64 s. Para cada tres ratas, el estímulo precedió al reforzador primario con un intervalo de 0, 1, 2, 4, 8, 16 o 32 s durante 40 sesiones. Cada sesión duró 32 minutos que era el tiempo necesario para que se entregaran 30 comidas.

Los valores del programa IA de presentaciones del estímulo y del programa TF de estímulo-comida se eligieron debido a que estos valores generaron tasas de respuestas substanciales en el estudio de Villegas et al. (2009).

Resultados

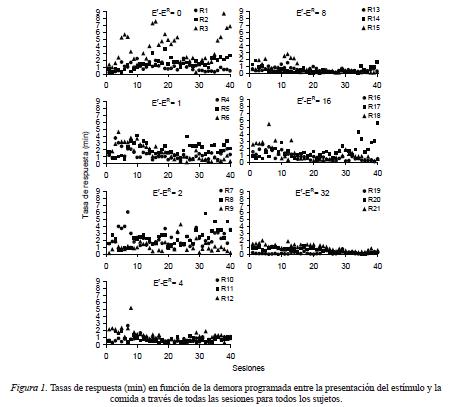

Estudios anteriores sobre la adquisición de nuevas respuestas han empleado diversos criterios para definir el fenómeno (e.g., Anderson & Elcoro, 2007). Sin embargo, ninguno de estos criterios ha logrado definir satisfactoriamente la transición entre una tasa de respuesta baja, típica del nivel incondicionado de la respuesta a una tasa más alta. Dado que la observación directa de la frecuencia de presionar la palanca en función del tiempo de exposición al procedimiento es el dato mas comúnmente reportado en estudios anteriores, en la Figura 1 se muestran las tasas de respuesta individuales a través de las 40 sesiones de cada intervalo entre el estímulo y el reforzador primario. A pesar de una considerable variabilidad en las tasas de respuesta intra y entre sujetos es posible apreciar que todas las ratas presionaron la palanca desde las primeras sesiones experimentales. Con los intervalos entre el estímulo y el reforzador primario de 0 a 2 s las tasas fueron generalmente más altas y tendieron a aumentar con el paso de las sesiones. Con los intervalos de 4 a 32 s, las tasas de respuesta fueron más bajas y o bien se mantuvieron constantes con el paso de las sesiones o tendieron a disminuir hacia el final de las 40 sesiones.

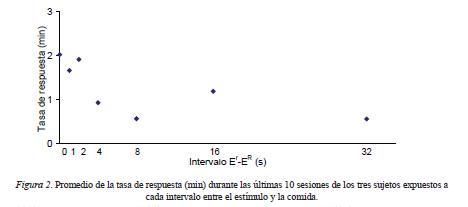

Con el fin de atenuar la variabilidad en los datos individuales, en la Figura 2 se presenta el promedio de la tasa de respuesta durante las últimas 10 sesiones de los tres sujetos expuestos a cada intervalo entre el estímulo y el reforzador primario. La tasa de respuesta promedio disminuyó conforme se alargó el intervalo entre las presentaciones independientes del estímulo y el reforzador primario.

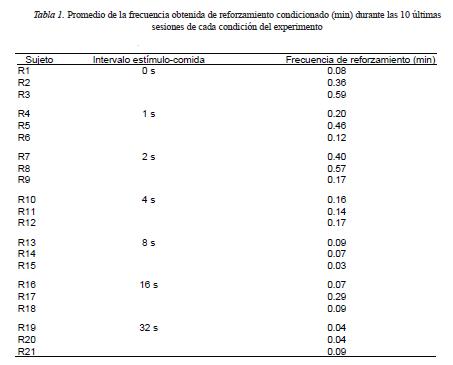

Dado que la frecuencia obtenida de ocurrencias del estímulo por presionar la palanca necesariamente varía respecto a la frecuencia programada dependiendo de la tasa de respuesta de cada sujeto, en la Tabla 1 se muestra este dato como el promedio de cada sujeto durante las diez últimas sesiones de cada condición del experimento. La frecuencia de producción del estímulo varió entre .06 y .38 por minuto y fue más alta en las condiciones en las que la duración del intervalo entre el estímulo y el reforzador primario fue de 0 y 2 s en comparación con las condiciones en las que el intervalo fue de 8 a 32 s, lo cual concuerda con el nivel de la tasa de respuesta alcanzado en esas condiciones.

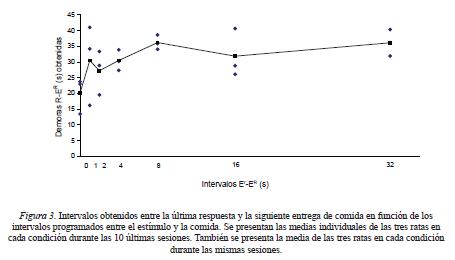

Dado que el programa TF 64 s de presentaciones independientes del estimulo y la comida permitía contigüidades accidentales entre respuestas por el estímulo y la entrega periódica de comida, en la Figura 3 se muestra para cada rata el intervalo respuesta-comida obtenido como el promedio de las últimas 10 sesiones en cada condición. Para los intervalos estímulo-comida entre 0 y 2 s, la separación temporal media entre la última respuesta y la siguiente comida varió alrededor de entre 20 y 28 s y para los intervalos de 4 hasta 32 s varió entre 30 y 36 s aproximadamente.

Discusión

El propósito de la presente investigación fue estudiar la adquisición y el posterior mantenimiento de la respuesta de presionar una palanca en ratas por un estímulo previamente neutral mientras se degradó gradualmente la condición óptima para dotar al estímulo con la función de reforzador condicionado. Usando el procedimiento de Villegas et al. (2009), se expuso a las ratas directamente al programa constante para obtener el estímulo (inmediato pero intermitente). Ninguna rata recibió entrenamiento preliminar conducente a presionar la palanca. Para cada tres ratas se alargó gradualmente el intervalo entre la presentación del estímulo y la comida independiente de la conducta. A pesar de que las tasas de respuesta fueron bajas y tuvieron una considerable variabilidad, es posible apreciar que alargar gradualmente el intervalo entre las presentaciones independientes del estimulo y la comida resultó en disminuciones más o menos graduales en la tasa de respuesta por el estímulo, a la manera de un gradiente de eficacia del estímulo como reforzador condicionado. Los resultados de este estudio aportan conocimientos pertinentes tanto a los procedimientos de Zimmerman y Hanford (1966) y de Villegas et al. (2009) como al estudio de la adquisición de nuevas respuestas con reforzamiento condicionado.

Respecto a los procedimientos de Zimmerman y Hanford (1966) y de Villegas et al. (2009), es conveniente mencionar que Zimmerman y Hanford mostraron en palomas que una vez establecida la respuesta por el estímulo suspender el programa de apareamientos del estímulo y el reforzador primario, resulta en que la respuesta que produce al estímulo no se mantenga. Por lo tanto, el programa concurrente de presentación del reforzador condicionado y el primario independiente de la conducta, es una condición necesaria para dotar al estímulo con la función de reforzador condicionado.

En un procedimiento complementario al de Zimmerman y Hanford (1966), Villegas et al. (2009) mostraron en ratas que manteniendo constante el programa de apareamientos del estímulo con la comida, una vez establecida la respuesta por el estímulo, suspender la entrega del estímulo resulta en la disminución de la respuesta a tasas bajas. Por lo tanto, la producción del estímulo es necesaria para el mantenimiento de la respuesta. Un control adicional en el experimento de Villegas et al. consistió en interrumpir las presentaciones contiguas del estímulo y la comida, manteniendo constante la presentación del estímulo después de cada respuesta. Tanto el estímulo como la comida siguieron ocurriendo, pero de tal forma que cada evento podía ocurrir en una relación temporal diferente del otro de ocasión en ocasión. Este control es semejante al conocido como "control verdaderamente al azar" de Rescorla (1967). Villegas et al. encontraron que la tasa de la respuesta de presionar una palanca por reforzamiento condicionado en ratas disminuyó a niveles bajos cuando se suspendió la relación constante de contigüidad entre el estímulo y la comida. Este control muestra que la respuesta que produce al estímulo no se mantiene debido al mero cambio en la estimulación, como sería el caso del reforzamiento sensorial de la respuesta (eg., Kish, 1966). También muestra que el sostenimiento de la respuesta que produce al estímulo no se mantiene debido al condicionamiento "supersticioso" de la respuesta (Skinner, 1948) o a un aumento en la actividad del sujeto, ambos debidos a la presencia de la comida (Richter, 1922).

En relación al control consistente en variar la relación temporal del estímulo y la comida de ocasión en ocasión (como en el procedimiento de Villegas et al. 2009 y en el de Rescorla, 1967), los resultados obtenidos en este estudio sugieren que la disminución en la eficacia de un estímulo como reforzador condicionado debido a su presentación en una relación temporal variable con el primario produce una especie de suma algebraica, en la cual el efecto de las ocasiones en las que el estímulo ocurre alejado temporalmente del primario restan eficacia al efecto de las ocasiones en las que el estímulo ocurre en cercanía temporal con el primario. En otras palabras, cualquier comparación entre la eficacia de un estímulo contiguo al primario mostraría que tal eficacia es necesariamente mayor a la eficacia de un estímulo que ocurre en una relación temporal variable con el reforzador primario (i.e., como en el procedimiento de Rescorla, 1967). En contraste con este tipo de comparación, en el presente estudio se mostró que el efecto de la separación temporal entre el reforzador condicionado y el primario no es un efecto de todo o nada, sino que es gradual, a la manera de un gradiente. Este hecho complementa el conocimiento del "control verdaderamente al azar" mostrando que el último representa una confusión deliberada de los efectos de separaciones variables entre el reforzador condicionado del primario.

Aparte de las aportaciones de la presente investigación al conocimiento del reforzamiento condicionado en los procedimientos de Zimmerman y Hanford (1966) y de Villegas et al. (2009), los resultados de la presente investigación añaden conocimiento al estudio de la adquisición de nuevas respuestas. Conforme a su propósito, el presente experimento es una primera extensión de los hallazgos de Lattal y Gleeson (1990), obtenidos con reforzamiento primario a la adquisición de nuevas respuestas con reforzamiento condicionado. En el mismo sentido de los experimentos hechos con reforzamiento primario, en el presente estudio también se intentó degradar las condiciones del reforzamiento condicionado de la nueva respuesta. Sin embargo, dado que las operaciones para establecer un reforzador primario (e.g., Michael, 1982) difieren de aquellas que dotan a un estímulo neutral con la función de reforzador condicionado, en la presente investigación se estudió la proximidad temporal entre el reforzamiento condicionado y la comida, en lugar de estudiar la privación del reforzador primario (e.g., Lattal & Williams, 1997).

Respecto a la condición óptima para dotar a un estímulo neutral con la función de un reforzador condicionado; i.e., la presentación contigua del estímulo y la comida, las tasas de respuesta obtenidas en el presente estudio (de alrededor de 2 respuestas por minuto en promedio) fueron considerablemente más bajas que las obtenidas por Villegas et al. (2009; de alrededor de 16 respuestas por minuto en promedio) usando el mismo valor del programa de reforzamiento condicionado inmediato por responder. La razón de esta discrepancia no es clara pero puede deberse a que mientras que en el estudio de Villegas et al. se empleó un programa de tiempo al azar (TA) de 64 s para las presentaciones del estímulo y la comida, en el presente estudio se empleó un programa de TF del mismo valor. El haber empleado un programa periódico para entregar la comida pudo haber permitido la formación de una discriminación temporal, facilitada aún mas por la presentación del estímulo en una relación temporal fija con la comida (i.e., a la manera de un reloj añadido), que controlaba que las ratas se acercaran al comedero hacia el final del intervalo fijo. Dado que acercarse al comedero es incompatible con presionar la palanca, esta característica del procedimiento De hecho, la Figura 3 muestra que para los intervalos entre 0 y 2 s, las ratas dejaron de presionar la palanca alrededor de 20 s antes de la siguiente entrega de comida. Para los intervalos de 4 a 32 s, la pausa antes de la entrega de la siguiente comida fue aún más larga. Estos datos sugieren que las respuestas se concentraron en los primeros dos tercios del intervalo entre comidas. Respecto a la posibilidad de que las respuestas fueran reforzadas accidentalmente por la siguiente comida, los mismos datos sugieren que no fue el caso.

De cualquier manera, tanto los resultados del presente estudio como el anterior de Villegas et al. muestran que la eficacia de un reforzador condicionado es considerablemente menor que la eficacia de un reforzador primario para establecer la respuesta de presionar la palanca en ratas. En un estudio efectuado por Bruner, Avila, Acuña y Gallardo (1998), las tasas de respuesta promedio de tres ratas expuestas directamente a un programa tandem IA 30 s TF 0 s fueron de alrededor de 30 respuestas por minuto.

Aún cuando las tasas de respuesta fueron bajas en este experimento, al alargar la separación entre el estímulo y la comida, las tasas de respuesta disminuyeron gradualmente, mostrando la efectividad de esta variable independiente. Este hallazgo no ha sido documentado en la literatura sobre la adquisición de nuevas respuestas con reforzamiento condicionado y permiten concluir que degradar la condición óptima de contigüidad entre el estímulo y el reforzador primario permite hasta cierto punto el establecimiento de una nueva respuesta, aunque sea con una tasa relativamente baja.

Referencias

Anderson, K., & Elcoro, M. (2007). Response acquisition with delayed reinforcement in Lewis and Fisher rats 344. Behavioural Processes, 74, 311-318. [ Links ]

Bersh, P. J. (1951). The influence of two variables upon the establishment of a secondary reinforcement for operant responses. Journal of Experimental Psychology, 41, 62-73. [ Links ]

Butter, C. M., & Thomas, D. R. (1958). Secondary reinforcement as a function of the amount of primary reinforcement. Journal of Comparative and Physiological Psychology, 51, 346-348. [ Links ]

Bruner, C. A., Avila, R., Acuña, L. & Gallardo, L. (1998). Effects of reinforcement rate and delay on the acquisition of leverpressing by rats. Journal of the Experimental Analysis of Behavior, 69, 59-75. [ Links ]

Catania, C. (1979). Learning. Englewood Cliffs, NJ: Prentice-Hall. [ Links ]

Critchfield, T. S., & Lattal, K. A. (1993). Acquisition of a spatially defined operant with delayed reinforcement. Journal of the Experimental Analysis of Behavior, 59, 373 387. [ Links ]

Ferster, C.B. (1953).The use of the free operant in the analysis of behavior. Psychological Bulletin, 50, 263-272. [ Links ]

Fox, R. E., & King, R. A. (1961). The effects of reinforcement-scheduling on the strength of a secondary reinforcer. Journal of Comparative and Physiological Psychology, 54, 266-269. [ Links ]

Galuzka, C. M., & Woods, J. H. (2005). Acquisition of cocaine self-administration with unsignaled delayed reinforcement in rhesus monkeys. Journal of the Experimental Analysis of Behavior, 84, 269-280. [ Links ]

Guthrie, E. R. (1935). The psychology of learning. Nueva York, E. U.: Harper. [ Links ]

Gollub, L. R. (1977). Conditioned reinforcement: Schedule effects. En W. K. Honig, & J. E. R. Staddon (Eds.), Handbook of operant behavior (pp. 288–312). Englewood Cliffs, NJ, E. U.: Prentice-Hall.

Hull, C. L. (1943). Principles of behavior. Nueva York, E. U.: Appleton- Century- Crofts. [ Links ]

Kelleher, R. T., & Gollub, L. R. (1962). A review of conditioned reinforcement. Journal of the Experimental Analysis of Behavior, 5, 543-597. [ Links ]

Keller, F. S., & Schoenfeld, W. N. (1950). Principles of psychology. Nueva York, E.U.: Appleton-Century- -Crofts. [ Links ]

Kimble, G. A. (1961). Hilgard and Marquis' conditioning and learning. Nueva York, E.U.: Appleton-Century- Crofts. [ Links ]

Kish, G. B. (1966) Studies of sensory reinforcement. En W. K. Honig (Ed.) Operant Behavior: areas of research and aplication (pp. 109-159), Nueva York: Appleton-Century-Crofts. [ Links ]

Lattal, K. A., & Gleeson, S. (1990). Response acquisition with delayed reinforcement. Journal of Experimental Psychology: Animal Behavior Processes, 16, 27-39. [ Links ]

Lattal, K. A., & Metzger, B. (1994).Response acquisition by siamese figthing fish (betta splendens) with delayed visual reinforcement. Journal of the Experimental Analysis of Behavior, 61, 35-44. [ Links ]

Lattal, K., & Williams, M. (1997). Body weight and response acquisition with delayed reinforcement. Journal of the Experimental Analysis of Behavior, 67, 131-143. [ Links ]

Michael, J. L. (1982). Distinguishing between discriminative and motivational functions of stimuli. Journal of the Experimental Analysis of Behavior, 37, 149-155. [ Links ]

Rescorla, R. (1967). Pavlovian conditioning and its proper control procedures. Psychological Review, 74, 71-80. [ Links ]

Richter, C.P. (1922) A behavioristic study of the activity of the rat. Comparative Psychology Monographs, 1, 279-280. [ Links ]

Skinner, B. F. (1938). The behavior of organisms: An experimental analysis. Nueva York, E. U.: Appleton-Century-Crofts. [ Links ]

Skinner, B. F. (1948). "Superstition" in the pigeon. Journal of Experimental Psychology, 38, 168-172. [ Links ]

Sutphin, G., Byrne, T., & Poling, A. (1998). Response acquisition with delayed reinforcement: A comparison of two-lever procedures. Journal of Experimental Analysis of Behavior, 69, 17-28. [ Links ]

Tolman, E. C. (1932). Purposive behavior in animals and men. Nueva York, E.U.: Appleton-Century. [ Links ]

Villegas, T., Bruner, C., & Hernández, V. (2009). La adquisición y el mantenimiento de presionar una palanca en ratas con reforzamiento condicionado. Acta Comportamentalia, 17, 155-170. [ Links ]

Zimmerman, D. (1957). Durable secondary reinforcement: Method and theory. Psychological Review, 64, 373-383. [ Links ]

Zimmerman, J., & Hanford, P. V. (1966). Sustaining behavior with conditioned reinforcement as the only response-produced consequence. Psychological Reports, 19, 391-401. [ Links ]

Received: April, 28, 2011

Accepted: October, 17, 2011

1 Este trabajo es parte del proyecto doctoral del primer autor, bajo la dirección del segundo. El primer autor agradece a CONACYT por la beca número 325906/229089 otorgada para realizar estudios de doctorado. Dirigir correspondencia a los autores a Laboratorio de Condicionamiento Operante, Facultad de Psicología, UNAM, Cd. Universitaria, Ave. Universidad 3004, Col. Copilco Universidad, México, D. F., 04510, México. Correos electrónicos: karinabr_@hotmail.com, cbruner@servidor.unam