Serviços Personalizados

artigo

Indicadores

Compartilhar

Revista Brasileira de Terapia Comportamental e Cognitiva

versão impressa ISSN 1517-5545

Rev. bras. ter. comport. cogn. vol.2 no.1 São Paulo jun. 2000

ARTIGOS

Conditioned reinforcement

Gerson Yukio Tomanari

Universidade de São Paulo

RESUMO

O presente trabalho é uma revisão de literatura em reforçamento condicionado, processo através do qual associações entre um estímulo inicialmente neutro e um reforçador já estabelecido tomam, o primeiro, um reforçador efetivo. Sobre os reforçadores condicionados, são revistos aspectos conceituais, parâmetros determinantes (número de pareamentos, magnitude do reforçador primário etc), metodologia empregada nas investigações (procedimentos de resistência à extinção, esquemas encadeados, respostas de observação, economia de fichas) e, finalmente, teorias que procuram descrever as condições mínimas necessárias para o seu estabelecimento e manutenção.

Palavras-chave: reforçamento condicionado, hipótese da redução do atraso, hipótese da redução da incerteza.

SUMMARY

The present paper reviews studies on the process by which a primarily neutral stimulus comes to exert reinforcing functions following associations with a formerly established reinforcer. The paper reviews conceptual aspects of conditioned reinforcement, its determining parameters (number of pairings, magnitude of reinforcement etc), the methods of investigation (procedures such as insistence to extinction, chained schedules, observing responses, token economy) and, finally, some theories that describe the fundamental conditions necessary to establish and maintain conditioned reinforcers.

Key words: conditioned reinforcement, delay reduction hypothesis, uncertainty reduction hypothesis.

Fortalecer um comportamento é uma das importantes funções exercidas por estímulos sobre o comportamento dos organismos (Keller e Schoenfeld, 1950). No âmbito do condicionamento operante, quando nos referimos ao fortalecimento de um comportamento ou, tecnicamente, ao reforçamento de uma resposta, estamos tratando dos efeitos, sobre o comportamento (responder), de eventos (estímulos) que o seguem e dele dependem. Um desses efeitos consiste no aumento da probabilidade de que o comportamento reforçado volte a ocorrer no futuro (Catania, 1998).

Em um processo de reforçamento, o evento que se segue à resposta reforçada, aquele responsável pelo seu fortalecimento, é chamado de estímulo reforçador. O estímulo reforçador é qualificado como positivo quando o reforçamento da resposta é contingente à apresentação deste, e qualificado como negativo quando o reforçamento da resposta é contingente à sua eliminação (fuga ou esquiva). Para citar alguns exemplos, estímulos que tipicamente exercem a função de reforçadores positivos são alimento, água, dinheiro. Estímulos que tipicamente exercem a função de reforçadores negativos são choque, um som extremamente alto, um calor muito intenso.

Alguns eventos reforçadores presentes no ambiente dos organismos caracterizam-se por sua capacidade inata de, nas devidas condições motivacionais, fortalecer comportamentos que os produzem (no caso de reforçadores positivos) ou que os eliminam (no caso dos reforçadores negativos). Estes eventos, tais como alimento, água, sexo etc, são chamados de estímulos reforçadores primários (ou, simplesmente, reforçadores primários, incondicionados ou incondicionais).

Diferentemente dos reforçadores primários, cuja função de fortalecer comportamento tem sido selecionada no decorrer do processo de seleção natural (Baum, 1994), eventos inicialmente neutros (i.e., eventos que não demonstram função reforçadora) podem adquirir e exercer função reforçadora através do processo de aprendizagem denominado reforçamento condicionado (conforme a designação de Skinner, 1938) ou secundário (conforme a designação de Hull, 1943). Respeitadas determinadas condições específicas (estados de privação, por exemplo), a associação entre um estímulo reforçador já estabelecido e um estímulo inicialmente neutro pode fazer com que o segundo passe a exercer função reforçadora (Catania, 1998; Kelleher e Gollub, 1962). No exercício desta função, este estímulo é denominado reforçador condicionado.

Dizemos que ocorre um processo de reforçamento condicionado quando podemos demonstrar que o estímulo em questão é de fato reforçador e que o efeito reforçador observado depende de um procedimento de condicionamento explícito (Nevin, 1973). Por exemplo, bicadas de um pombo, eliciadas pela iluminação de um disco de respostas, não envolvem o processo de reforçamento condicionado. Para se falar em reforçamento condicionado, duas condições devem ser satisfeitas:

1. o estímulo em questão deve ter uma história de associação com um reforçador já estabelecido, primário ou condicionado;

2. o estímulo deve aumentar a probabilidade de uma resposta que o produz (se associado com um reforçador positivo), ou de uma resposta que o elimina (se associado com um reforçador negativo).

O conceito de reforçamento condicionado teve origem no paradigma de condicionamento clássico ou respondente. Neste, dada uma resposta incondicionada (ou incondicional) eliciada por um estímulo incondicionado (ou incondicional), uma história de pareamento entre o estímulo incondicionado e um estímulo inicialmente neutro pode fazer com quem este segundo passe a eliciar respostas (respostas condicionadas ou condicionais), semelhantes àquelas eliciadas pelo estímulo incondicionado, enquanto for mantido o pareamento ou persistirem seus efeitos (Catania, 1998). Em ambos os condicionamentos respondente e operante, a função reforçadora condicionada dos estímulos depende da manutenção da associação dos mesmos com reforçadores estabelecidos. Além disso, assim como ocorre com os reforçadores primários, um estado motivacional, promovido por uma operação estabelecedora (Michael, 1982), deve existir para que um reforçador condicionado seja efetivo.

O processo de reforçamento condicionado no paradigma de condicionamento operante, âmbito ao qual o presente trabalho irá se restringir, é um processo extremamente importante para atividades complexas em seres humanos (Keller e Schoenfeld, 1950). Uma vez estabelecido, um reforçador condicionado pode fortalecer outras respostas além daquelas envolvidas durante o seu estabelecimento, e pode fazer isso por outras razões além daquelas que prevaleciam durante o treino original. Isso caracteriza um reforçador generalizado. Em seres humanos, dinheiro e frases como "muito bem!" freqüentemente funcionam como reforçadores condicionados generalizados para muitos comportamentos, nas mais distintas situações, independentemente de qualquer motivação específica.

Uma importante função dos reforçadores condicionados é manter o comportamento cios organismos quando reforçadores primários não estão disponíveis. Por exemplo, quando tentamos ligar o carro e ele não entra em funcionamento, insistimos e giramos a chave um maior número de vezes quando o motor "dá algum sinal de vida", em comparação com a situação em que o motor fica completamente apagado. O som produzido quando tentamos dar a partida no carro, nesse exemplo, poderia ser designado como um reforçador condicionado, uma vez que girar a chave seria um comportamento por ele mantido.

Outra importante função dos reforçadores condicionados refere-se à aquisição de seqüências de respostas. Por exemplo, quando um aluno estuda para uma prova, dificilmente faz isso por causa da conseqüência distante que é receber o diploma quando se graduar. Mais provavelmente, o aluno estuda para a prova para obter aprovação (ou evitar reprovação) na disciplina, uma conseqüência bem mais próxima. No entanto, esta conseqüência imediata é parte de uma seqüência de respostas, tecnicamente chamada de cadeia de respostas, na qual a aprovação na disciplina é apenas um requisito necessário que, assim como muitos outros, irá permitir que o aluno complete a cadeia e, no final, obtenha o reforçador principal, a graduação.

Por fim, os reforçadores condicionados têm-se mostrado relevantes para as investigações que envolvem controle de estímulos (Dinsmoor, 1995). Estudos em respostas de observação demonstram que estímulos discriminativos exercem função reforçadora condicionada (Wyckoff, 1952, 1969) e, portanto, o processo de reforçamento condicionado e o processo de discriminação de estímulos mantêm estreitas relações.

Uma das primeiras demonstrações empíricas de reforçamento condicionado foi feita por Skinner (1938). Desde então, reforçamento condicionado tem sido amplamente investigado, tanto experimentalmente quanto conceitualmente. O engajamento de pesquisadores nessa área se justifica. Conforme aponta Dinsmoor (1983), reforçamento condicionado é um conceito necessário quando os princípios derivados do laboratório, com reforçadores primários, são aplicados ao comportamento em ambiente natural, onde a maior parte dos reforçadores não é inata e está envolvida em padrões complexos de comportamento.

Métodos de investigação

O valor reforçador condicionado de estímulos mereceria uma medida pura, isolada de outros fatores. Mas essa medida é impossível, uma vez que se trata de um fenômeno comportamental especialmente complexo (Nevin, 1973). O simples fato de o reforçador condicionado poder desempenhar, concomitantemente, funções discriminativa e reforçadora, dimensiona esta complexidade.

As dificuldades intrínsecas às investigações do reforçamento condicionado refletem-se na diversidade de procedimentos empregados por investigadores na área. Uma breve revisão dos principais procedimentos utilizados será apresentada a seguir.

Resistência à extinção

Reforçamento condicionado pode ser estudado por um método simples, porém não muito eficiente, de extinção. Inicialmente, o sujeito é submetido a uma fase de reforçamento, contingente à emissão de uma resposta específica, na presença de um estímulo que, inicialmente, não demonstra funções obviamente reforçadoras ou aversivas (SI). O caso de um rato em uma caixa de condicionamento operante seria um exemplo de situação em que pressões à barra são mantidas pela apresentação de água antecedida pelo som proveniente do mecanismo do bebedouro (S1). A seguir, na ausência do reforçador primário, mas na presença do som do bebedouro, avalia-se o valor reforçador adquirido por S1 na manutenção de respostas à barra. Em geral, após a aquisição da resposta, dois grupos de sujeitos são formados. Cada um deles é submetido a uma das seguintes condições. Em uma, as respostas anteriormente mantidas pelo reforçador primário são seguidas apenas pelo estímulo S 1. Na outra condição, as respostas não têm qualquer conseqüência. Utilizando este arranjo experimental, Bugelski (1938), descrito por Fantino e Logan (1979), observou a ocorrência de 30% mais respostas na condição em que apenas S1 (som) era apresentado, em comparação com a situação em que as respostas não tinham qualquer conseqüência. Isto estaria demonstrando o efeito reforçador condicionado de S1. A situação descrita anteriormente, envolvendo a tentativa de dar partida em um carro quebrado, seria semelhante à que vigora no procedimento de resistência à extinção.

A despeito da simplicidade deste procedimento, este não tem se mostrado eficiente para o estudo de reforçamento condicionado. O seu principal problema é o fato de os testes serem realizados em extinção, condição que impõe que o valor reforçador do estímulo seja avaliado justamente quando a sua função reforçadora está se enfraquecendo devido à interrupção do pareamento de S1 com o reforçador primário. Além disso, neste procedimento, a condição de teste em que as respostas produzem o estímulo S1 é semelhante à condição de treino no que se refere à presença do estímulo SI. A condição de teste comparativa, por outro lado, é mais distinta, uma vez que S1 não é apresentado. Em vista disso, as respostas que, aparentemente, são mantidas apenas por SI, podem ser, simplesmente, produto da generalização oriunda desta semelhança.

Nevin (1973) destaca uma outra dificuldade imposta pelo procedimento de resistência à extinção, que é a própria remoção do reforço primário. Durante o teste de reforçamento condicionado, a ausência do reforçador primário pode ter efeitos sobre o comportamento do sujeito que complicam seriamente a avaliação do reforçamento condicionado. Por exemplo, a remoção do reforçador primário pode gerar respostas emocionais (ratos mordendo a barra de respostas, por exemplo) que, certamente, interferem na condição de teste.

Cadeias comportamentais

Como foi mencionado anteriormente, uma importante função dos reforçadores condicionados refere-se à aquisição e à manutenção de cadeias comportamentais (Ferster e Skinner, 1957). A seqüência de tarefas que compõe a trajetória de um aluno em um curso de graduação exemplifica uma cadeia comportamental longa e complexa.

Em cadeias comportamentais, dois ou mais componentes - muitas vezes chamados de elos - operam sucessivamente e o reforçamento ocorre somente depois que as exigências de todos os elos são cumpridas. Em cadeias (ou esquemas encadeados), cada componente é sinalizado por um estímulo exteroceptivo distinto. Este estímulo serve como reforçador da resposta que o antecede e como discriminativo da resposta que o segue. Por exemplo, em um esquema encadeado FI 4 min FR 60, o componente de FI, acompanhado por som contínuo, seria o elo inicial (estaria mais distante do reforço), e o componente de FR, acompanhado por som intermitente, seria o elo terminal (estaria mais próximo do reforço). Eliminando-se do esquema encadeado as apresentações dos estímulos exteroceptivos correlacionados com os seus diferentes componentes, tem-se o chamado esquema tandem.

A principal vantagem de se utilizar esquemas encadeados para o estudo de reforçamento condicionado está no fato de que, nestes-, procede-se com a medida do valor reforçador do estímulo sob condições estáveis e comparáveis, já que o reforçador primário é mantido durante o teste, diferentemente do que ocorre no procedimento de resistência à extinção. Além disso, porque os esquemas encadeados não exigem a remoção do reforçador primário, evitam-se os efeitos indesejáveis dessa operação. No entanto, o que elimina as desvantagens do procedimento de resistência à extinção traz, em si, outro problema, que é o fato de os efeitos do reforçador primário e do reforçador condicionado poderem se confundir, pois, no encadeamento, a produção de reforçadores condicionados deve-se, em parte, à produção do reforçador primário ao final da cadeia. Por fim, os componentes que não precedem imediatamente a apresentação do reforçador primário (i.e., os componentes iniciais de uma cadeia) correlacionam-se com a ausência deste e, por isso, o responder nestes componentes iniciais pode enfraquecer-se e impossibilitar a manutenção da cadeia. Por exemplo, pombos privados de comida mantêm o responder nas condições em que respostas ao disco, sob esquema tandem FR 200, produzem apresentações do comedouro. Entretanto, o esquema encadeado FR 50 FR 50 FR 50 FR 50, idêntico ao tandem FR 200 no que se refere ao número de respostas por reforçamento, não mantém o responder destes mesmos sujeitos (Catania, 1998).

Economia de fichas

Uma instância de aplicação e estudo de cadeias comportamentais é conhecida por economia de fichas. Nesta, fichas plásticas, por exemplo, atuam como reforçadores condicionados generalizados e mantêm comportamentos temporalmente distantes do reforçador principal.

A utilização de reforçadores condicionados generalizados na manutenção de comportamentos complexos pode ser exemplificada em estudos clássicos com macacos (Cowles, 1.937; Wolfe, 1936) nos quais os sujeitos foram ensinados a pressionar uma alavanca que liberava fichas que, posteriormente, eram trocadas por uvas passas em uma máquina (Cowles, 1937). Wolf (1936) demonstrou que, por meio das fichas, era possível haver ura atraso entre a resposta de pressionar a alavanca e a obtenção da uva sem que este atraso enfraquecesse o comportamento. Enquanto os macacos podiam segura as fichas, as respostas à alavanca se mantinham.

Além de técnica de experimentação, a economia de fichas tem sido aplicada em contextos de saúde e educação (Kazdin, 1983). Fantino e Logan (1979) apontam dois objetivos freqüentemente relacionados à economia de fichas. O primeiro é instalar e manter comportamentos desejáveis no decorrer das condições de tratamento; o segundo é promover uma forma de facilitar a manutenção destes comportamentos, depois que o tratamento tenha sido descontinuado, transferindo o controle exercido pelas fichas a reforçadores naturais (aprovação social, por exemplo). "Porque as fichas são pareadas não com um, mas com vários reforçadores diferentes, eles são potentes reforçadores condicionados generalizados" (Fantino e Logan, 1979, p. 187).

A generalidade das fichas na manutenção de diferentes comportamentos, em particular, e dos próprios reforçadores condicionados, de forma geral, é de especial relevância para o próprio conceito de reforçamento condicionado. Nevin (1973), nesse aspecto, é categórico ao afirmar que "a importância do reforçador condicionado reside, em grande parte, na demonstração de sua generalidade" (Nevin, 1973, p. 183). Conforme afirma, no ambiente natural, os organismos são submetidos a variações constantes em seu ambiente. Se os efeitos do reforçamento condicionado não pudessem ser demonstrados sob mudanças de condições, o conceito seria muito pouco útil fora das condições controladas do laboratório. Nesse sentido, dados de pesquisa têm mostrado que um estímulo que adquire função reforçadora condicionada em uma situação específica pode atuar como reforçador em uma situação diferente daquela em que ocorreu o pareamento (D'Amato, 1955; Estes, 1949; Hayes, Kohlenberg e Hayes, 1991; Skinner, 1938; Zimmerman, 1959).

Esquemas encadeados concorrentes

O uso típico de esquemas encadeados concorrentes nas investigações de reforçamento condicionado emprega duas diferentes chaves de resposta nas quais vigoram, simultaneamente, dois esquemas encadeados de dois componentes cada. A programação dos esquemas é tal que os sujeitos podem obter todos os reforçadores primários disponíveis distribuindo suas respostas nas duas chaves. Normalmente, o número de reforçadores é igual em ambas. Utilizando pombos, por exemplo, os componentes iniciais de ambos os esquemas encadeados são normalmente sinalizados pela cor branca. Os seus componentes finais são sinalizados por cores distintas, verde e vermelho, por exemplo. A distribuição,das respostas dos sujeitos entre os dois discos, durante a vigência do componente inicial, é uma medida relativa do valor reforçador condicionado dos estímulos discriminativos produzidos, as cores verde e vermelha em suas respectivas cadeias. Utilizando os esquemas encadeados concorrentes, Fantino (1969) identificou variáveis temporais fundamentais para o estabelecimento de reforçadores condicionados. A hipótese da redução do atraso, modelo teórico de reforçamento condicionado que será apresentado oportunamente, descreve com precisão estas variáveis.

Respostas de observação

Um procedimento largamente utilizado para se investigar reforçamento condicionado é o procedimento de respostas de observação, originalmente proposto por Wyckoff (1952, 1969). O objetivo deste autor, na ocasião, era compreender o estabelecimento de uma discriminação. Wyckoff, no entanto, não dispunha de instrumental para investigar respostas naturais de observação (olhar para, direcionar-se para etc). Por isso, desenvolveu o procedimento no qual os organismos, para terem contato com os estímulos discriminativos, deviam emitir uma resposta artificial de observação, arbitrariamente definida, discreta e mensurável, tal como pressionar uma barra ou pisar em um pedal. Atualmente, há recursos tecnológicos modernos, tais como o ISCAN®, que permitem estudar as respostas de observação naturais e, inclusive, correlacioná-las com as respostas de observação artificiais (Tomanari, Bálsamo, Fowler e Dube, 1997).

Um procedimento típico de respostas de observação utiliza alternações de esquemas múltiplo e misto. Inicialmente, os sujeitos são submetidos ao esquema múltiplo formado por componentes em que vigoram alternações aleatórias de dois esquemas diferentes (VI 30 s e Extinção, por exemplo) correlacionados a dois estímulos exteroceptivos distintos (estímulos discriminativos). A seguir, os sujeitos são expostos à condição de avaliação da função reforçadora condicionada dos estímulos discriminativos. Nesta, transforma-se o esquema múltiplo em esquema misto. No esquema misto, eliminam-se os estímulos discriminativos correlacionados com os dois esquemas. No entanto, durante a fase de esquema misto, uma segunda chave de respostas torna-se operativa (chave de observação). Respostas à chave de observação (respostas de observação) transformam o esquema misto em múltiplo por um determinado tempo ou pelo tempo que perdurar a emissão da resposta de observação.

No experimento pioneiro de Wyckoff (1952), pombos foram expostos a alternações de períodos de reforçamento (FI30 s) e extinção. Um pedal próximo aos discos era o manipulando que, se acionado, produzia a apresentação dos estímulos relacionados aos componentes em vigor. Os dados de Wyckoff mostraram que os pombos pisavam no pedal e produziam os estímulos discriminativos, o que demonstrou a função reforçadora condicionada destes.

Uma característica importante em relação às respostas de observação é o fato de que elas não alteram a programação de reforços atribuída a respostas na chave principal. As respostas de observação são mantidas apenas pelos estímulos sinalizadores que produzem, não sendo seguidas diretamente por reforçadores primários ou por mudanças na probabilidade de ocorrência destes. Em função disto, o procedimento foi eleito como a "melhor técnica disponível para demonstrar a legitimidade e a importância do próprio conceito de reforçamento secundário ou condicionado" (Dinsmoor, 1983, p. 696). Adicionalmente, o procedimento de respostas de observação permite um maior refinamento no estudo de reforçadores condicionados quando comparado com os procedimentos anteriormente descritos. No procedimento de respostas de observação, é possível avaliar a função reforçadora condicionada adquirida pelo estímulo que sinaliza a maior probabilidade de reforçamento (S+), separada e comparativamente, do estímulo que sinaliza a menor probabilidade de reforçamento (S-).

Parâmetros do reforçamento condicionado

A "força" ou o "valor" reforçador de um estímulo refere-se à medida de quanto este mantém comportamento (i.e., a quantidade de respostas mantidas pelo estímulo reforçador), o quão resistente à extinção um comportamento previamente mantido por este estímulo é, e quanto este estímulo é preferido em relação a outros estímulos (Fantino e Logan, 1979). A força de um reforçador condicionado na manutenção do comportamento é variável e pode depender de uma série de fatores, alguns dos quais serão apontados a seguir.

Função discriminativa dos estímulos

Estímulos discriminativos exercem função de reforçadores condicionados. Ou seja, dada a oportunidade, e mantendo-se outros fatores constantes, sujeitos expõem-se preferencialmente à situação em que estão presentes estímulos discriminativos das contingências em vigor alternativamente à situação em que não estão (Harsh e Badia, 1 974; Prokasy, 1956). As funções discriminativas e reforçadoras dos estímulos se correlacionam diretamente. Na medida em que a discriminação é adquirida, o valor reforçador dos estímulos se fortalece (Wyckoff, 1969, descrito adiante).

Em seu estudo pioneiro, Prokasy (1956) procurou avaliar a hipótese de Wyckoff ( 1952) de que "a exposição a estímulos discriminativos terá um efeito reforçador na resposta de observação na medida em que o sujeito tiver aprendido a responder diferencialmente a estímulos discriminativos" (Wyckoff, 1952 - p. 435). O procedimento utilizado consistiu em submeter ratos a tentativas em um labirinto em forma de "E". Uma tentativa tinha início no eixo central e encerramento em um dos eixos laterais, onde os sujeitos podiam encontrar comida. A probabilidade de reforçamento primário, nos dois eixos, era igual a 0,5. As paredes dos dois eixos laterais eram pintadas de branco ou preto. A existência ou não de correlação sistemática entre a cor das paredes e a existência ou ausência de comida diferenciava os eixos esquerdo e direito do labirinto. Enquanto em um dos lados as cores consistentemente discriminavam as condições de apresentação ou não de comida, no outro, as cores não se correlacionavam com estas duas condições. Os resultados obtidos neste estudo mostraram que os sujeitos, inicialmente, distribuíam suas escolhas igualmente entre os dois lados do labirinto. Com o transcorrer das sessões, verificou-se um aumento crescente no número de escolhas pelo lado do labirinto em que as cores dos compartimentos discriminavam as condições de apresentação e não apresentação de comida. Ou seja, os sujeitos produziram estímulos discriminativos das condições em vigor, caracterizando os estímulos discriminativos produzidos como reforçadores condicionados.

Os dados descritos por Prokasy (1956) podem ser generalizados para a situação em que vigoram contingências de reforçamento negativo. Harsh e Badia (1974), por exemplo, mostraram que ratos demonstram uma preferência inequívoca por condições em que a liberação de choques é sinalizada, em comparação à alternativa em que não é. Nesse estudo, ratos foram expostos a apresentações imprevisíveis de choques a cada dois minutos, em média. Pressionando-se uma barra, os ratos tornavam, durante um minuto, os choques normalmente não sinalizados em choques previamente sinalizados por uma breve apresentação de um som. Os resultados foram claros em mostrar que os sujeitos pressionavam a barra, expondo-se à situação em que os choques eram sinalizados.

Número de pareamentos

Segundo alguns estudos, a efetividade de um estímulo como reforçador condicionado relaciona-se diretamente com o aumento no número de pareamentos deste com o reforçador primário (Bersh, 1951; Fantino e Hermstein, 1968; Hall, 1951; Miles, 1956).

Miles (1956) realizou um experimento utilizando ratos como sujeitos. Inicialmente, os sujeitos passaram por uma fase de reforçamento contínuo da resposta de pressionar uma barra. Estas respostas eram conseqüenciadas pela apresentação de comida acompanhada pelo som advindo do acionamento do comedouro e também pelo piscar de uma luz. Nesta fase, os sujeitos, em grupos distintos, foram expostos a um número diferente de reforçamentos (e, portanto, de pareamentos entre a comida e o som do comedouro acompanhado pela luz). Na fase seguinte, respostas à barra foram colocadas em extinção. Para metade dos sujeitos de cada grupo, respostas à barra, em extinção, foram conseqüenciadas somente pelo som do comedouro e pela apresentação da luz, Para a outra metade, as respostas não tinham conseqüência alguma. Os resultados mostraram que houve um número maior de respostas para os sujeitos que, durante a extinção, produziam os estímulos som do comedouro e luz, comparativamente àqueles cujas respostas à barra não tinham conseqüência alguma, revelando a função reforçadora condicionada exercidapor estes estímulos. Além disso, verificou-se que o número de respostas em extinção era progressivamente maior quanto maior o número de reforçamentos (pareamentos) a que os ratos haviam sido submetidos previamente.

Magnitude do reforçador primário

De modo geral, a magnitude do reforçador primário parece afetar a força do reforçador condicionado (Butter e Thomas, 1958; D'Amato, 1955; Neuringer, 1969). No experimento realizado por D'Amato (1955), ratos eram colocados em um dos extremos de um corredor e deviam percorrê-lo para obter comida no extremo oposto. A depender da cor das paredes do corredor, brancas ou pretas, os sujeitos encontravam cinco pelotas de comida ou apenas uma ao final do percurso. Após esta fase de treino, os sujeitos passaram por uma fase de teste, em extinção, em um labirinto em forma de "T". Um dos braços do labirinto era pintado na cor branca; o outro era pintado na cor preta. Durante o teste, os resultados mostraram que os ratos adentravam significativamente mais o lado do labirinto cuja cor havia sido associada à maior magnitude do reforçador primário.

Atraso do reforça mento primário

A força de um reforçador condicionado varia em função da duração do intervalo entre a sua apresentação e a apresentação do reforçador primário. Na medida em que este intervalo aumenta, o reforçador condicionado se torna mais enfraquecido. O estudo de Bersh (1951) demonstra esta relação. Neste, ratos recebiam uma pelota de comida após 0; 0,5; 1,0; 2,0; 4,0; ou 10 segundos de uma lâmpada ser acesa. Os sujeitos foram expostos a 160 pareamentos de luz e comida. A seguir, foram colocados em uma caixa operante em que havia uma barra de respostas. Respostas à barra produziam 1 segundo de apresentação de luz. Os resultados mostraram que a maior freqüência de respostas ocorreu para os sujeitos que foram submetidos ao intervalo de 0,5 s durante o treino. Quanto maior o intervalo, menor foi freqüência de respostas mantidas pela apresentação de luz.

Esquemas do reforçamento primário

O valor reforçador condicionado de um estímulo é afetado pelo esquema que, na sua presença, vigora para o reforçamento primário. Há dados que sugerem que, para o estabelecimento do reforçador condicionado, apresentações intermitentes do reforçador primário são mais efetivas do que apresentações contínuas (Fantino e Logan, 1979).

Segundo Nevin (1973), "comportamento reforçado intermitentemente é muito mais resistente à extinção do que o comportamento reforçado continuamente" (Nevin, 1973, p. 177). Não seria estranho, portanto, que o comportamento mantido intermitentemente por reforçador condicionado seja igualmente mais resistente à extinção do que o comportamento reforçado continuamente. Em favor disso, há estudos mostrando que o reforçador primário e o reforçador condicionado são funcionalmente semelhantes no que se refere ao padrão de respostas gerado por esquemas de reforçamento (Zimmerman, Hanford e Brown, 1967).

Teorias de reforço condicionado

Freqüentemente, o valor reforçador condicionado de um estímulo é tratado genericamente como sendo produto da associação deste com um reforçador previamente estabelecido (Baum, 1994; Catania, 1998). Raramente, ao se tratar de reforçamento condicionado discute-se a questão sobre "que tipo de associação seria necessária para que um estímulo neutro se torne um reforçador condicionado" (Keller e Schoenfeld, 1950). Como afirmam Fantino e Logan (1979), no nível teórico de conceituação de reforçamento condicionado, devemos especificar melhor o que significa dizer que um estímulo associado ao reforçador primário adquire valor reforçador condicionado. O que queremos dizer por "associação"? Que operações devemos fazer para tomar um estímulo, inicialmente neutro, em um reforçador? Quais as condições mínimas necessárias para isso?

Historicamente, diferentes hipóteses foram elaboradas na tentativa de se identificar as variáveis relevantes no estabelecimento de um reforçador condicionado. No entanto, a maioria delas não se mostrou suficientemente adequada aos dados experimentais que foram sendo produzidos na área. Entre elas, estão as hipóteses do estímulo discriminativo (Keller e Schoenfeld, 1950) e a hipótese do pareamento (Hull, 1943), brevemente revistas a seguir.

Hipótese do estímulo discriminativo

De acordo com a hipótese do estímulo discriminativo (Keller e Schoenfeld, 1950, previamente sugerida por Skinner, 1938), "de modo a atuar como um reforçador condicionado para uma dada resposta, um estímulo deve ter o status de um estímulo discriminativo para alguma resposta"(p. 236). Embora esta hipótese esteja correta, pois, de fato, as funções discriminativas e reforçadoras condicionadas de estímulos se correlacionam, esta é uma hipótese relativamente genérica. Além disso, há dados que sugerem que estímulos podem manter-se reforçadores condicionados mesmo depois de deixarem de ser discriminativos (Fantino e Logan, 1979), ou mesmo sem nunca terem sido, já que respostas de observação são mantidas por estímulos sinalizadores de reforçamento independente de resposta (Blanchard, 1975; Mulvaney, Dinsmoor e Jwaideh, 1974; Tomanari, Machado e Dube, 1998).

Hipótese do pareamento

Segundo a hipótese do pareamento (Hull, 1943), um estímulo pareado com um reforçador primário adquire propriedades reforçadoras condicionadas. No entanto, o mero pareamento ou a simples contiguidade de um estímulo neutro com reforçador primário já se mostrou não ser condição suficiente para tomá-lo um reforçador condicionado (Rescorla, 1968, 1972).

Atualmente, predominam na área duas hipóteses de reforçamento condicionado, as chamadas hipótese da redução da incerteza (ou hipótese da informação) e hipótese da redução do atraso.

Hipótese da redução da incerteza

Em linhas gerais, a hipótese da redução da incerteza sustenta que o valor reforçador condicionado de um estímulo depende do quanto ele informa sobre a disponibilidade ou a ausência do reforçador primário (Berlyne, 1957; Hendry, 1969). Segundo Berlyne (1957), a produção de informação seria reforçadora na medida em que a incerteza seria aversiva para os organismos.

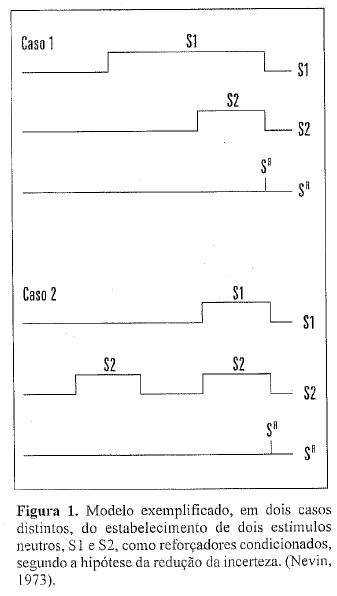

Considere o seguinte exemplo em que dois estímulos, S1 e S2, são apresentados imediatamente antes do reforçador primário conforme esquematizam os Casos 1 e 2 na Figura 1 (Nevin, 1973; Tomanari, 1995).

Segundo a hipótese da redução da incerteza, o estímulo neutro S1 torna-se um reforçador condicionado tanto no Caso 1 quanto no Caso 2. No Caso 1, S1 é informativo da chegada do reforçador primário, enquanto S2 é redundante, já que a informação acerca do reforçador incondicionado é fornecida de antemão pelo estímulo S1. No Caso 2, S1 é um preditor confiável da chegada do reforçador primário, enquanto S2 não é; nem todas as vezes que S2 é apresentado, ele prediz sobre a chegada do reforçador primário. Em síntese, segundo a hipótese da redução da incerteza, um estímulo atua como reforçador condicionado em função de quanto ele informa ou prediz acerca do reforçador primário.

Para testar empiricamente esta hipótese, Egger e Miller (1962) realizaram um estudo para avaliar a força de dois estímulos S1 e S2, como reforçadores condicionados, dado que estes estímulos poderiam assumir valor informativo ou redundante em relação à apresentação do reforçador primário. Ratos albinos, sob privação de alimento, separados em dois grupos, foram submetidos a três fases experimentais. Após treino de pressão à barra, os dois grupos passaram por um treino de associação de estímulos. Para os sujeitos do Grupo A, S1 era apresentado, sendo seguido por S2 e, em seguida, pela apresentação de comida (SI = informativo e S2 = redundante), como o Caso 1, Figura 1. Para os sujeitos do Grupo B, como no Caso 2 da Figura 1, somente em 55% das apresentações S2 era acompanhado por comida, enquanto que todas as apresentações de S1 eram seguidas de comida (SI - preditor confiável e S2 - preditor não confiável). Na segunda fase, as respostas à barra foram colocadas em extinção. Na terceira fase, para todos os sujeitos, respostas à barra produziam S1 ou S2, em duas sessões de teste distintas. Os resultados mostraram que S1 revelou-se um reforçador condicionado mais forte (mantinha taxas mais elevadas de respostas à barra na terceira fase) tanto para os sujeitos do Grupo A (Caso 1) quanto do Grupo B (Caso 2). No Caso 1, S1 era informativo. No Caso 2, era um preditor confiável da chegada do reforçador primário.

Os resultados de Egger e Miller (1962), poitanto, corroboram as predições da hipótese da redução da incerteza. No entanto, segundo contrapõem Dinsmoor (1983) e Fantino e Logan (1979), é possível que, simplesmente, os sujeitos não tenham atentado às apresentações de S2 quando este era "redundante" (Caso 1) e "um preditor não confiável" (Caso 2). Ou seja, os resultados obtidos por Egger e Miller (1962) teriam sido produto de um fraco controle de estímulos, não de uma avaliação do valor reforçador dos estímulos.

Dados que fornecem suporte à hipótese da redução da incerteza estão presentes, principalmente, na literatura em respostas de observação. Basicamente, são estudos que mostram que o estímulo sinalizador de menor ou nula probabilidade de apresentação de reforçador primário (S-), muitas vezes sinalizador de extinção, mantém respostas de observação. Quando S- sinaliza períodos de extinção, seria o caso em que um estímulo nunca associado com reforçador primário estaria exercendo função reforçadora em decorrência, segundo os autores que advogam pela hipótese da redução da incerteza, da informação produzida (Lieberman, 1972; Lieberman, Cathro, Nichol e Watson, 1997; Perone e Baron, 1980; Schier, Thompson e Spector, 1980).

Hipótese da redução do atraso

Segundo a hipótese da redução do atraso (Fantino, 1977), a eficiência de um estímulo como reforçador condicionado se estabelece em função da distância temporal entre a apresentação deste estímulo e a chegada do reforçador primário. Trata-se de uma medida relativa ao estado anterior à apresentação do estímulo. Quanto maior a porcentagem de redução temporal sinalizada pelo estímulo correlacionado com o reforçador primário, maior será o seu valor reforçador condicionado (Fantino, 1977).

Tecnicamente, essa redução ao reforçador pode ser especificada em termos da razão entre dois intervalos médios; o intervalo entre dois reforçamentos sucessivos e o intervalo entre o início do estímulo que precede o reforçador e o próprio reforçador.

Exemplificando: no caso de um esquema de tempo fixo de 100 segundos (FT 100 s), o intervalo entre dois reforçadores primários é de 100 segundos. Um estímulo S1 que seja apresentado no 30º segundo após a liberação do último reforçador estará sinalizando uma redução de 30% no tempo até o próximo reforçador. Um estímulo S2, que seja apresentado no 70º segundo após o último reforçador, estará sinalizando uma redução de 70% do intervalo até o reforçador seguinte (Figura 2).

Segundo a hipótese da redução do atraso, o estímulo S2 adquire um valor de reforçador condicionado mais forte, se comparado com SI, uma vez que sinaliza a maior redução no atraso do reforço ou, em outras palavras, sinaliza a maior proximidade do reforço primário.

A maior parte dos dados disponíveis na literatura em respostas de observação dá suporte à hipótese da redução do atraso, pois demonstram que o estímulo correlacionado com maior probabilidade de reforçamento (S+), em comparação com o estímulo correlacionado com nula ou menor probabilidade de reforçamento (S-), mantém, ou mantém mais fortemente, respostas de observação (Allen e Lattal, 1989; Fantino e Case, 1983; Case, Ploog e Fantino, 1990, entre outros). Em conformidade com a hipótese da redução do atraso, S+ é, justamente, o estímulo que, em relação ao estímulo presente durante o esquema misto, sinaliza redução no tempo até a apresentação do reforçador primário. Em contrapartida, S- mantém menos respostas de observação, ou mantém respostas que o evitam, demonstrando ausência de propriedade reforçadora ou presença de propriedade aversiva condicionada (Blanchard, 1975; Tomanari e col., 1998). Estes resultados corroboram a hipótese da redução do atraso, uma vez que a apresentação de S- sinaliza, em relação ao estímulo presente durante o esquema misto, aumento no tempo até o reforçador primário.

Além dos dados provenientes dos estudos em respostas de observação, a hipótese da redução do atraso encontra suporte em dados obtidos em condicionamento respondente (Dinsmoor, 1983) e, principalmente, nos estudos que empregam esquemas encadeados concorrentes (Fantino, 1969). Esta forte consistência e generalidade dos dados que corroboram a hipótese da redução do atraso tem sustentado, esta, como o mais importante modelo de reforçamento condicionado atualmente disponível.

Conclusões

Por meio de associações a reforçadores já estabelecidos, estímulos inicialmente neutros passam a exercer função reforçadora condicionada e manter respostas que os produzem (no caso de reforçamento positivo) ou que os evitam (no caso de reforçamento negativo). Investigações experimentais sobre reforçamento condicionado têm identificado vários de seus parâmetros (por exemplo, número de pareamentos, magnitude do reforço primário, esquemas de reforçamento etc) utilizando diferentes procedimentos (resistência à extinção, esquemas encadeados, respostas de observação, entre outros). Trata-se de um fenômeno complexo sobre o qual a ciência do comportamento tem-se comprometido não apenas a descrevê-lo, mas a tentar identificar e compreender seus determinantes. Nesse sentido, várias hipóteses para explicá-lo já foram formuladas. Atualmente, duas delas predominam, a hipótese da redução da incerteza e a hipótese da redução do atraso. A hipótese da redução do atraso, formulada por Fantino (1977), é a que tem encontrado o maior suporte e consistência em dados de experimentos em resposta de observação, esquemas encadeados concorrentes, e condicionamento respondente. Segundo esta hipótese, tomam-se reforçadores condicionados estímulos que, em relação ao estado vigente, sinalizam uma redução (ou um aumento, no caso de reforçamento negativo) no tempo desde a sua apresentação até a chegada do reforçador primário.

Referências

Allen, IC.D. e Lattal, K. A. (1989) On conditional reinforcing effects of negative discriminative stimuli. Journal of Experimental Analysis ofBehavior, (12),335-339. [ Links ]

Baum, W.M. (1994) Understanding Behaviorism: Science, Behavior, and Culture. New York: HarperCollins. [ Links ]

Berlyne, D. E. (1957) Uncertainty and conflict: A point of contact between information theory and behavior theoiy concepts. Psychological Review, (54),329-333. [ Links ]

Bersh, P. J. (1951) The influence of two variables upon the establishment of a secondary reinforcer for operant responses. Journal of Experimental Psychology, (41),62-73. [ Links ]

Blanchard, R. (1975). The effect of S - on observing behavior. Learning and Motivation, (6),1-10. [ Links ]

Butter, CM. e Thomas D.R. (1958). Secondary reinforcement as a function of the amount of primary reinforcement. Journal of Comparative and Physiological Psychology, (57), 346-348. [ Links ]

Case, D.A.; Ploog, B.O. e Fantino, E. (1990). Observing behavior in a computer game. Journal of Experimental Analysis of Behavior, (54),185-199. [ Links ]

Catania, C.A. (1998). Learning -4th. ed. New Jersey: Prentice Hall. [ Links ]

Cowles, J.T. (1937). Food-tokens as incentive for learning by chimpanzees. Comparative Psychology Monographs, (14),5. [ Links ]

D'Amato, M.R (1955). Secondary reinforcement and magnitude of primary reinforcement. Journal of Comparative and Physiological Psychology, (48),378-380. [ Links ]

Dinsmoor, J.A. (1983). Observing and conditioned reinforcement. Behavioral and Brain Sciefices, (6),693-728. [ Links ]

______ (1995). Stimulus control. The Behavior Analyst, (18),51.-68; 253-269. [ Links ]

Egger, M.D. e Miller, N.E. (1962). Secondary reinforcement in rats as a function of information value and reliability of the stimulus. Journal of Experimental Psychology, (64),97-104. [ Links ]

Estes, W.K. (1949). Generalization of secondary reinforcement from the primary drive. Journal of Comparative and Physiological Psychology, (42),286-295. [ Links ]

Fantino, E. (1969). Conditioned reinforcement, choice, and the psychological distance to reward. Em D.P. Hendry (ed.). Conditioned reinforcement. Homewood, III.: Dorsey Press. [ Links ]

______ (1977). Conditioned reinforcement: choice and information. In W.K. Honig e J.E.R. Staddon (orgs.). Handbook of operant behavior. New Jersey: Prentice Hall. [ Links ]

______ e Case, D.A. (1983). Human observing: Maintained by stimuli correlated with reinforcement but not extinction. Journal of Experimental Analysis of Behavior, (40),193-210. [ Links ]

______ e Herrnstein, R.J. (1968). Secondary reinforcement and number of primary reinforcements. Journal of the Experimental Analysis of Behavior, (77),9-14. [ Links ]

______ e Logan. C.A. (1979). Conditioned reinforcement. In The experimental analysis of behavior: A biological perspective. New York: W. H. Freeman. [ Links ]

Ferster, C.B. e Skinner, B.F. (1957). Schedules of reinforcement. New York; Appleton-Century-Crofts. [ Links ]

Hall, J.F. (1951). Studies in secondary reinforcement I. Secondary reinforcement as a function of the frequency of primary reinforcement. Journal of Comparative and Physiological Psychology, (44),240-251. [ Links ]

Harsh, J. e Badia, P. (1974). A concurrent assessment of the positive and negative properties of a signaled shock schedule. Animal Learning and Behavior, (2),169-172. [ Links ]

Hayes, S.C.; Kohlenberg, B.S. e Hayes, L.J. (1991). The transfer of specific and general consequential functions through simple and conditional equivalence relations. Journal of the Experimental Analysis of Behavior, (56),119-137. [ Links ]

Hendry, D.P. (1969). Conditioned reinforcement. ITomewood, III.: Dorsey Press.

Hull, C.L. (1943). Principles of behavior. New York: Appleton-Century-Crofis. [ Links ]

Kazdin, A.E. (1983). The token economy: A decade later. Journal of Applied Behavior Analysis, (75),431-445. [ Links ]

Keller, F.S. e Schoenfeld, W.N. (1950). Principles of psychology. New York: Appleton-Century-Crofts. [ Links ]

Kelleher, R.T. e Gollub, L.R. (1962). A review of positive conditioned reinforcement. Journal of the Experimental Analysis of Behavior, (5),543-597. [ Links ]

Lieberman, D.A. (1972) Secondary reinforcement and information as determinants of observing behavior in monkeys (Macaco mulatto). Learning and Motivation, (3),341-358. [ Links ]

______ Cathro, S.S.; Nichol, K. e Watson, E. (1997). The role of S- in human observing behavior: bad news is sometimes better than no news. Learning and Motivation, (28),20-42. [ Links ]

Michael, J. (1982). Distinguishing between discriminative and motivational functions of stimuli. Journal of the Experimental Analysis of Behavior, (37),149-155. [ Links ]

Miles, R.C. (1956) The relative effectiveness of secondary reinforcers throughout deprivation and habit-strength parameters. Journal of Comparative and Physiological Psychology, (49),126-130. [ Links ]

Mulvaney, D.E.; Dinsmoor, J.A.; Jwaideh, A.R. e Hughes, LIT. (1974). Punishment of observing by the negative discriminative stimulus. Journal of the Experimental Analysis of Behavior, (21),37-44. [ Links ]

Neuringer, A.J. (1969). Delayed reinforcement versus reinforcement after a fixed interval. Journal of the Experimental Analysis of Behavior, (72),375-383. [ Links ]

Nevin, J.A. (1973). Conditioned reinforcement. In J.A. Nevin e G.S. Reynolds (eds.). The study of behavior. Glenview: Scott. Foresman. [ Links ]

Perone, M. e Baron, A. (1980). Reinforcement of human observing behavior by stimulus correlated with extinction or increased effort. Journal of Experimental Analysis of Behavior, (34),239-261. [ Links ]

Prokasy, W.F. (1956) The acquisition of observing responses in the absence of differential external rein forcement. Journal of Comparative and Physiological Psychology, (49),131-134. [ Links ]

Rescorla, R.A. (1968). Probability of shock in the presence and absence of CS in fear conditioning. Journal of Comparative and Physiological Psychology, (66),1-5. [ Links ]

______ (1972) Informational variables in Pavlovian conditioning. In G. Bower (Ed.). The psychology of learning and motivation, vol. 6. New York; Academic Press. [ Links ]

Schrier, A.M.; Thompson, CR. e Spector, N.R. (1980). Observing behavior in monkeys (Macaca arctoides): Support for the information hypothesis. Learning and Motivation, (11),355-365. [ Links ]

Skinner, B.F. (1938). The behavior of organisms. New York: Appleton-Century-Crofts. [ Links ]

Tomanari, G.Y. (1995). Contingências determinantes da resposta de observação. Dissertação de Mestrado. São Paulo: IPUSP. [ Links ]

______ Balsamo, L.M.; Fowler, T.R. eDube, W.V. (1997). Correspondence between artificial and natural observing responses in human subjects. Encontro Anual da Southeastern Association for Behavior Analysis - SEABA. Chapel Hill. NC. [ Links ]

______ Machado, L.M. e Dube, W. (1998). Pigeons' observing behavior and response-independent food presentations. Learning and Motivation. (29),249-260. [ Links ]

Wolfe, J.B. (1936). Effectiveness of token-rewards for chimpanzees. Comparative Psychology Monographs, (12),1-72. [ Links ]

Wyckoff Jr, L.B. (1952). The role of observing responses in discrimination learning. Psychological Review, (59),431-442. [ Links ]

______ (1969). The role of observing responses in discrimination learning. In D.P. Hendry (Ed.). Conditioned reinforcement. Homewood, III: Dorsey Press. [ Links ]

Zimmerman, D.W. (1959) Sustained performance in rats based on secondary reinforcement. Journal of Comparative and Physiological Psychology, (52),353-358. [ Links ]

Zimmerman, J.; Hanford, P.V. e Brown, W. (1967). Effects of conditioned reinforcement frequency in an intermittent free-feeding situation. Journal of the Experimental Analysis of Behavior, (10),331-340. [ Links ]

Endereço para correspondência:

Endereço para correspondência:

Instituto de Psicologia USP

Av. Prof. Mello Moraes, 1721

São Paulo, SP 05508-900

Tel (11) 3818-4444 ramal 211 - Fax (11) 3818-4357

Email:tomanari@usp.br